Didaktik: Unterschied zwischen den Versionen

(→Aufgabenformate/Prüfungsitems) |

|||

| Zeile 36: | Zeile 36: | ||

=== Technologien aussuchen === | === Technologien aussuchen === | ||

* siehe [[Technik und Systeme]] | * siehe [[Technik und Systeme]] | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

== Qualitätssicherung == | == Qualitätssicherung == | ||

| Zeile 138: | Zeile 66: | ||

==== Kriterien im Spannungsfeld ==== | ==== Kriterien im Spannungsfeld ==== | ||

Die genannten Kriterien können sich gegenseitig beeinflussen. Ein Beispiel: setzt man genügend Mittel und Zeit ein (Ökonomie), ist es möglich, eine Prüfung sehr objektiv, reliabel und valide zu gestalten. Das erhöht ebenso die Akzeptanz unter den Prüflingen. Sind hingegen hohe Reliabilität und Akzeptanz nicht wichtig, ist eine auch mit geringerem Mitteleinsatz möglich. Diese Faktoren sind jeweils im Einzelfall abzuwägen. | Die genannten Kriterien können sich gegenseitig beeinflussen. Ein Beispiel: setzt man genügend Mittel und Zeit ein (Ökonomie), ist es möglich, eine Prüfung sehr objektiv, reliabel und valide zu gestalten. Das erhöht ebenso die Akzeptanz unter den Prüflingen. Sind hingegen hohe Reliabilität und Akzeptanz nicht wichtig, ist eine auch mit geringerem Mitteleinsatz möglich. Diese Faktoren sind jeweils im Einzelfall abzuwägen. | ||

| + | |||

| + | == Sonstiges == | ||

| + | * [[Fragetypen | Verschiedene Aufgabentypen]] | ||

| + | * [[MC-Fragen erstellen | Erstellen von Multiple-Choice-Aufgaben]] | ||

== Noch auszuarbeitende Themen == | == Noch auszuarbeitende Themen == | ||

Version vom 1. März 2011, 12:26 Uhr

Inhaltsverzeichnis

Einsatzentscheidungen

Einsatzszenario auswählen

Zunächst sind Zweck und Ziele einer elektronischen Prüfung zu bestimmen. Denkbare Einsatzgebiete sind z.B.:

- Studienorientierung und Studienberatung: Orientierung geben, typische Fragen und Probleme des gewünschten Fachgebiets präsentieren und erproben, Stärken und Schwächen von Kandidaten ermitteln, Empfehlungen für Studiengänge erteilen

- Zulassungs- und Einstufungstests: Geeignete Kandidaten auswählen, Vorhandensein notwendigen Vorwissens oder von Vorleistungen sicherstellen, passende Kurse bestimmen, um Studierende nicht zu über- oder unterfordern

- Vor- und Nachbereitung von Lehrveranstaltungen: Lehrveranstaltungen an Vorwissen anpassen, Zeitmanagement optimieren, Feedback zum Verständnis der Inhalte im Anschluss einholen

- Clicker & Audience Response Systems: Wissen, Stimmungen und Meinungen bereits innerhalb einer Lehrveranstaltung abfragen, direkte Reaktionsmöglichkeit, Anregen von Diskussionen zum jeweils aktuellen Thema

- Gemeinsames Lernen: Unterstützen gemeinsamen Lernens, Zuteilung individueller Aufgaben, Förderung der Diskussion zum Lösungsweg, individuelle Anwendung auf eigene Aufgaben

- Quizzes & Zwischentests: Wiederholung von Inhalten, weiteren Aufnahmekanal zur Verfügung stellen, Feedback zum Verständnis geben

- Vorher/Nachher-Prüfungen: Kenntnisse bzw. Leistungen vor und nach dem Lernprozess vergleichen, um neben dem Stand des Prüflings auch den konkreten Lernerfolg des Lernprozesses zu bestimmen

- Elektronische Klausuren: Bewertung des Lernerfolgs im Anschluss an einen Lernprozess, Benotung von Leistungen

- Distanzprüfungen: Durchführen von Prüfungen und Bewerten von Leistungen auf Distanz

- Elektronische Lehrevaluationen: Ermitteln der Zufriedenheit mit Lehrveranstaltungen, Erheben von Verbesserungsvorschlägen, Qualitätssicherung

- Elektronische Klausurschränke: Vorbereitung auf Prüfungen, Sammeln typischer Fragen mit Lösungen, kein Zugriff für Lehrende

- Progresstests: Ermitteln des Lernfortschritts im Rahmen einer kompletten Ausbildung durch regelmäßige Erhebungen

In der Abbildung (rechts) sind diese verschiedene Szenarien eingeordnet in eine Matrix nach Relevanz für den Studienverlauf und der Notwendigkeit nach Überwachung. So ist eine benotete E-Klausur (oben rechts) z.B. sehr relevant für den weiteren Studienverlauf, da ein Scheitern daran ein Studium im schlimmsten Fall beenden kann. Aus diesem Grund finden E-Klausuren i.d.R. in überwachter Umgebung statt. Quizzes oder Zwischentests (unten links) hingegen sind kaum relevant für den Studienverlauf. Studierende können sie beliebig oft durchführen, z.B. bis sie das Thema verstanden haben. Eine Aufsicht ist dazu nicht nötig. Es scheint eine gute Idee zu sein, für den Einstieg in E-Prüfungen nicht direkt mit "gefährlichen" Szenarien zu beginnen, sondern ungefährlichere auszuwählen. Lehrende können auf diese Weise leicht den Umgang mit den neu eingesetzten Technologien lernen und deren Zuverlässigkeit erproben.

Ist die Entscheidung für ein bestimmtes Szenario gefallen, ist im nächsten Schritt eine geeignete Metapher zu bestimmen, welche die Verwendung elektronischer Verfahren erleichtert. Soll z.B. eine bereits schriftlich vorliegende Version lediglich "elektronisiert" werden, damit diese die Lernenden auch auf anderen Kanälen als bisher erreichen kann? Oder sollen ganz neue Wege gegangen werden, die z.B. multimediale Elemente einbeziehen, die in der traditionellen schriftlichen Form nicht einbezogen werden konnten?

Eine detaillierte Beschreibung verschiedener Möglichkeiten mit zugehörigen Praxisbeispielen findet sich in der Übersicht über verschiedene Einsatzszenarien. Eine Übersicht über die Experten zu den einzelnen Szenarien und dafür eingesetzte Technologien findet sich in der Kompetenzmatrix.

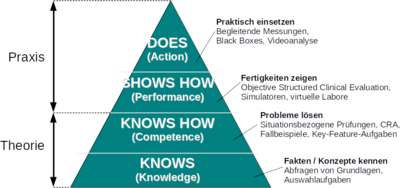

Professionalisierungsebene bestimmen

Abhängig davon, wie weit ein Lernender auf dem Weg vom Anfänger zum Experten fortgeschritten ist, stehen unterschiedliche Möglichkeiten zur elektronischen Leistungsmessung zur Verfügung. Es gilt nun, die jeweilige Ebene der Kompetenzentwicklung zu identifizieren und zugehörige passende Verfahren auszuwählen.

- Wissen: Lernende kennen die Grundlagen des jeweiligen Fachgebiets, angemessene Prüfungen benutzen zur Ermittlung des Wissensstandes z.B. Multiple-Choice-Aufgaben.

- Kompetenz: Lernende können mit Hilfe ihres Grundlagenwissens typische Probleme lösen. Angemessene Prüfungen konfrontieren Lernende mit neuen Situationen oder Fallbeispielen, deren Probleme sie mit ihrem Wissen lösen sollen.

- Leistung: Lernende zeigen praktische Abläufe, ohne diese jedoch in der regulären Praxis einzusetzen. Möglichkeiten, um das elektronisch zu überprüfen, bieten z.B. virtuelle Labore, Simulatoren oder Operationen an virtuellen Patienten.

- Handlung: Lernende setzen ihre Fertigkeiten in der Praxis ein. Entsprechendes Verhalten kann z.B. durch Black Boxes, Videoanalysen oder der Tätigkeit angepasste Aufzeichnungsmethoden festgehalten und analysiert werden.

Ein Prüfender wählt denjenigen Typ Prüfung aus, der dem jeweiligen Professionalisierungsgrad der Lernenden entspricht. Abhängig davon, wie praxisorientiert eine Hochschule ihre Studierenden ausbildet, sind somit verschiedene Möglichkeiten elektronischer Leistungsmessung denkbar. Das bedeutet aber auch, dass grundlegende Formen wie das Abprüfen von Wissen mittels MC-Fragen für alle Hochschulen in Frage kommen kann.

Ablauf festlegen

Technologien aussuchen

- siehe Technik und Systeme

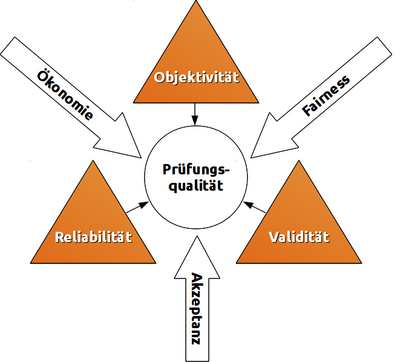

Qualitätssicherung

Gütekriterien eines Tests

Lienert & Raatz[1] sowie Amelang & Schmidt-Atzert[2] identifizieren verschiedene Gütekriterien eines Tests. Stieler[3] untersucht diese Kriterien für den pädagogischen Bereich, insbesondere zur Gestaltung von Klausuren.

Hauptgütekriterien

Bauen aufeinander auf, wobei jede Stufe ist nur nach Erfüllung der vorhergehenden zu erreichen ist.

- Objektivität: Unabhängigkeit vom Untersucher; verschiedene Prüfer kommen bei gleichen Prüflingen zum gleichen Ergebnis.

- bei Durchführung der Prüfung (Durchführungsobjektivität)

- bei Auswertung der Antworten (Auswertungsobjektivität)

- bei Interpretation der Ergebnisse (Interpretationsobjektivität)

- Reliabilität: Grad der Messgenauigkeit; Wiederholungen erbringen bei gleichen Beteiligten gleiche Ergebnisse.

- durch Paralleltests: streng vergleichbare Tests wiederholen

- durch Retests: gleichen Test wiederholen

- innere Konsistenz: messbar z.B. als Cronbachs Alpha

- durch Testhalbierung: Test in gleichwertige Hälften teilen und als 2 eigene Tests auswerten (siehe Paralleltest)

- durch Konsistenzanalyse: Ermittlung der Reliabilität auf indirektem Weg über Aufgabenschwierigkeit und Trennschärfe

- Validität: Ergebnisse des Tests korrelieren mit den zu prüfenden Kompetenzen.

- Inhaltsvalidität: Test prüft Wissen/Kompetenzen/Leistung, die mit Lehrzielen übereinstimmen.

- Konstruktvalidität Test ist geeignet, inhaltliche Kompetenzen zu erfassen (und nicht z.B. die Fähigkeit des Prüflings, Gedanken in kurzer Zeit aufzuschreiben/einzugeben).

- Kriteriumsvalidität: Testergebnisse stimmen mit empirischem Kriterium überein, das bereits vorliegt (konkurrente Validität, z.B. Schulnoten) oder erst später erkennbar wird (prognostische Validität, z.B. Studienerfolg).

Nebengütekriterien

- Akzeptanz: Test ist für Prüflinge transparent; keine Normen werden verletzt.

- Ökonomie: Nutzen übersteigt Kosten.

- Chancengerechtigkeit/Fairness: Gleiche Voraussetzungen für alle.

Kriterien im Spannungsfeld

Die genannten Kriterien können sich gegenseitig beeinflussen. Ein Beispiel: setzt man genügend Mittel und Zeit ein (Ökonomie), ist es möglich, eine Prüfung sehr objektiv, reliabel und valide zu gestalten. Das erhöht ebenso die Akzeptanz unter den Prüflingen. Sind hingegen hohe Reliabilität und Akzeptanz nicht wichtig, ist eine auch mit geringerem Mitteleinsatz möglich. Diese Faktoren sind jeweils im Einzelfall abzuwägen.

Sonstiges

Noch auszuarbeitende Themen

- Auswahl geeigeneter Aufgabenformate/Prüfungsitems

- Einsatzmöglichkeiten z.B. im Rahmen von "inquiry-based learning" (z.B. http://www.pi-project.ac.uk/)

- Frageerstellung nach didaktischen Gesichtspunkten

- Aufbau bzw. Einbeziehung fachlicher Fragepools

- Feststellen des Schwierigkeitsgrads der erstellten Aufgaben

- Festlegen des Prüfungsverlaufs (statisch, adaptiv, stufenförmig)

- Prüfungserstellung und Ablaufplanung

- Prüfungsvorbereitung, Durchführung Übungsklausuren

- Statistische Auswertung der Ergebnisse, Itemanalyse

Literaturnachweise

- ↑ Gustav A. Lienert, Ulrich Raatz: Testaufbau und Testanalyse, 6. Auflage, ISBN-13: 978-3621274241, BeltzPVU, 1998, bei Google Books

- ↑ Manfred Amelang, Lothar Schmidt-Atzert: Psychologische Diagnostik und Intervention, 4. Auflage, ISBN-13: 978-3540284628, Springer, Berlin, 2006, bei Google Books

- ↑ Jona Florian Stieler: Validität summativer Prüfungen - Überlegungen zur Gestaltung von Klausuren, ISBN: 3-938076-36-4, Janus Presse, Bielefeld, 2011, Download als PDF