Aufgabentypen

Inhaltsverzeichnis

Unterscheidungskriterien

Im Folgenden sind verschiedene Aufgabentypen mit Beispielen aufgelistet und ihre Besonderheiten beschrieben. Viele Prüfungstechnologien unterstützen zumindest grundlegende Fragetypen. Eine Gegenüberstellung der verschiedenen Systeme mit jeweils unterstützten Aufgabentypen findet sich im Funktionsumfang ausgewählter E-Prüfungssysteme.

Die nachfolgend als geschlossenen Fragen beschriebenen Typen geben Antworten vor, die vom Prüfling ausgewählt oder in eine passende Reihenfolge gebracht werden müssen (Wiedererkennens- und Selektionsleistung), während offene Fragen eine Reproduktionsleistung verlangen, da ein Prüfling zugehörige Antworten selbst erstellen muss. Als sonstige Fragen sind die Fragetypen eingeordnet, die über offene Fragen hinaus weitere multimediale Möglichkeiten nutzen. Eine Analyse verschiedener Frageformate und zugehöriger Lehrziele findet sich z.B. bei Stieler[1].

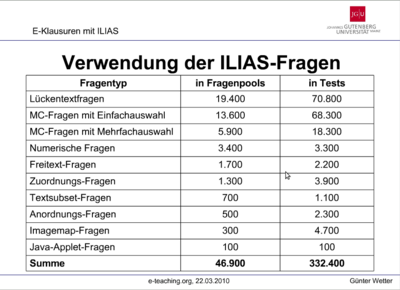

Weil Multiple-Choice-Aufgaben korrekte Antworten vorgeben, sind sie vollständig automatisiert und damit effizient auswertbar. Trotz ihres anfänglich verstärkten Einsatzes, hat an der Universität Mainz, die seit 2004 benotete elektronische Klausuren durchführt, die Anzahl gestellter Lückentextfragen die Zahl der Multiple-Choice-Aufgaben inzwischen überholt, wie die nebenstehende Abbildung zeigt.

Geschlossene Aufgaben

Geschlossene Aufgaben geben verschiedene Antwortalternativen vor, die von einem Prüfling dann ausgewählt oder in eine korrekte Reihenfolge gebracht werden müssen. Der Prüfling erbringt auf diese Weise eine Wiedererkennens- und Selektionsleistung. Im Folgenden werden die Anordnungs und die Auswahlaufgabe unterschieden sowie das Key-Feature-Problem erläutert. Case und Swanson[2] beschreiben in Appendix A ihres Artikels verschiedene Typen von Antwortwahlaufgaben, eine Übersicht folgt.

| Typ | Name |

|---|---|

| A | Einfachauswahlaufgabe |

| B | Zuordnungsaufgabe |

| C | A/B/beide/keine-Aufgabe |

| D | komplexe Zuordnungsaufgabe |

| E | Verknüpfungsaufgabe |

| H | Vergleichsaufgabe |

| I | Abhängigkeitsaufgabe |

| K | komplexe Richtig/Falsch‐Aufgabe |

| K' | Kombinationsaufgabe |

| R | erweiterte Zuordnungsaufgabe |

| X | einfache Richtig/Falsch‐Aufgabe |

| Pick N | Mehrfachauswahlaufgabe |

Anordnungsaufgabe

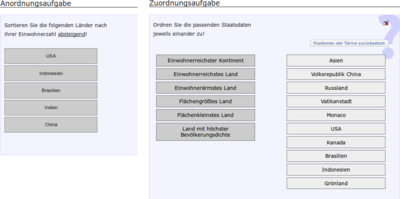

Bei der Anordnungsaufgabe werden eine Reihe verschiedener Elemente zur Verfügung gestellt, der ein Prüfling in eine bestimmte Reihenfolge bringen, sie einander zuzuordnen oder sie zueinander in Beziehung setzen soll. Das kann durch Drag&Drop-Verfahren gehen oder durch die Bereitstellung zugeordneter Auswahllisten und zugehörigen Positionsnummern. Je nachdem, wie die Elemente zugeordnet werden sollen, sind verschiedene Subtypen unterscheidbar.

- Anordnung/Reihenfolge: Bei dieser Form müssen die bereitgestellten Elemente in eine geforderte Anordnung oder Reihenfolge gebracht werden. Beispiele sind Schritte einer Methode, die der Reihe durchgeführt werden müssen, eine zeitliche Einordnung historischer Persönlichkeiten, das Sortieren von Städten nach ihrer Einwohnerzahl oder die Anordnung vorgegebener Organe an die passenden Positionen im menschlichen Körper.

- Zuordnung/Beziehung: Handelt es sich hingegen um eine Zuordnungsaufgabe, stehen zwei Listen zur Verfügung, deren Elemente jeweils sinnhaft einander zuzuordnen sind. Beispiele für Zuordnungen sind Staatsoberhäupter zu Ländern, Eigenschaften zu Organen oder historische Fakten zu Jahreszahlen.

Auswahlaufgabe

Bei diesem Aufgabentyp werden zu einer Frage verschiedene Antworten vorgegeben. Der Prüfling hat die Aufgabe, die jeweils richtigen Antwortalternativen zu identifizieren und zu markieren. Entsprechende Alternativen können auch in Form von Abbildungen oder Formeln dargestellt werden. Falsche Antwortalternativen (Distraktoren) müssen jedoch plausibel sein, damit der Prüfling nicht durch bloßes Ausschließen unsinniger Möglichkeiten die richtige Antwort herleiten kann. Je mehr Antwortmöglichkeiten angeboten werden, umso geringer ist die Wahrscheinlichkeit für eine zufällig richtig ausgewählte Lösung.

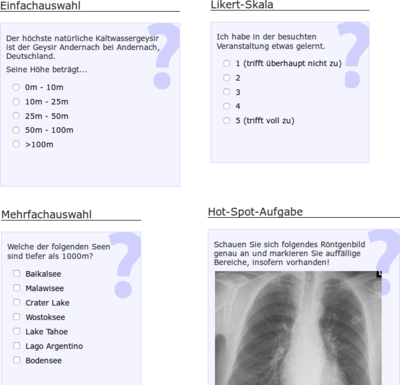

- Einfachauswahlaufgabe (Single Choice, Forced Choice): Ist nur eine der vorgegebenen Antwortalternativen korrekt, spricht man von einer Einfachauswahlaufgabe, auch Single Choice oder Forced Choice Aufgabe genannt. Im Spezialfall der True/False-Aufgabe stehen nur zwei Antwortmöglichkeiten zur Verfügung, nämlich "wahr" und "falsch". Hierbei muss der Prüfling entscheiden, ob eine vorab getätigte Aussage korrekt ist oder nicht. Problem dabei ist, dass aufgrund von nur zwei Antwortmöglichkeiten das zufällige Treffen/Raten der korrekten Lösung mit 50% Wahrscheinlichkeit sehr hoch ist. Daher sollten True/False-Aufgaben mit weiteren Aufgaben eines anderen Typs kombiniert werden.

- Likert-Skala: Eine Spezialisierung der Einfachauswahl ist die Likert-Skala, bei der eine bestimmte Reichweite vorgegeben wird, in der ein Prüfling einen bestimmten Sachverhalt einordnen soll (z.B. von 1="trifft voll" zu bis 7="trifft überhaupt nicht zu"). Dieser Typ wird z.B. gerne für Evaluationen eingesetzt.

- Mehrfachauswahlaufgabe (Multiple Choice): Bei einer Mehrfachauswahlaufgabe oder Multiple Choice Aufgabe stehen mehrere markierbare Antwortalternativen zur Verfügung. Die Auswahlmöglichkeiten des Prüflings reichen hierbei von 0 (keine Antwort ist richtig) bis n (alle Aussagen sind korrekt). Nur jene Prüflinge, die zugeordnete Lernziele erreicht haben, sollen eine solche Aufgabe richtig beantworten. Laut Jacobs[3] können MC-Aufgaben fast alle Lernziele erfassen, auch auf höherem Niveau (Verständnis, Anwendung). Der Aufgabenstamm kann dabei als Frage formuliert werden oder als unvollständiger Satz, der durch nachfolgende Möglichkeiten vervollständigt wird. Bei den sog. "interpretative exercises" gehen bestimmte Informationen voran, zu denen in Folge mehrere Fragen gestellt werden. Einer solchen Frage folgt dann eine Auswahl korrekter Antworten und Distraktoren. Dabei ist die zutreffende Antwort entweder wahr und alle Distraktoren falsch (true answer form) oder die beste Auswahl unter den Alternativen (best answer form). Der in [4] und [5] beschriebene Typ "Discrete Option Multiple Choice" fragt die Antwortmöglichkeiten der Reihe nach ab, so dass nie die gesamte Liste zu sehen ist.

- Hot-Spot-Aufgabe: Spezialisierung der Mehrfachauswahlaufgabe ist die Hot-Spot- oder Image-Map-Aufgabe. Prüflinge müssen bestimmte Bereiche (sog. Hot-Spots) auf einer gegebenen Abbildung (der Image-Map) markieren. Medizinische E-Prüfungen nutzen dieses Verfahren z.B. für Aufgaben rund um Röntgenbilder. Prüflinge sollen darauf erkrankte Regionen erkennen und hervorheben. Da dies ihrer typischen Tätigkeit entspricht, ist hierbei große Praxisnähe gegeben. Die Qualität der Darstellung ist durch Beteiligung elektronischer Medien häufig besser als auf gedruckten oder kopierten Aufgabenblättern. Zudem haben Prüflinge die Möglichkeit, durch "Heranzoomen" kritische Stellen genauer zu betrachten.

Bei 4 Antwortoptionen liegt die Wahrscheinlichkeit, eine richtige Antwort zu treffen, bei 25%. Da Studierende aber nicht nur als Zufallsgeneratoren funktionieren, sondern gewisses Vorwissen mitbringen, hängt die Qualität einer Auswahlaufgabe insbesondere von der Wahl guter Distraktoren ab.

Aufgrund eines Urteils vom OVG Nordrhein-Westfalen (Az. 14 A 2154/08) ist das Abziehen von Punkten für falsche Antworten nicht erlaubt bzw. rechtlich problematisch. Daher sollte man themenverwandte Bereiche zu einer Gesamtaufgabe zusammenziehen und diese als Einheit bewerten.

Key-Feature-Aufgaben

Die vorab beschriebenen Auswahlaufgaben helfen dabei, das Vorhandensein insbesondere deklarativen Wissens zu überprüfen, was laut Miller[6] einer unteren Ebene der Professionalisierung entspricht. Um darüber hinaus auch prozedurales Wissen und damit eine situationsbezogene Anwendung des grundlegenden Wissens erfassen zu können, sind komplexere Verfahren notwendig. Kopp, Möltner und Fischer[7] schlagen dazu Key-Feature-Aufgaben vor, welche die Entscheidungskompetenz der Prüflinge testen sollen. Die sog. Key-Features sind dabei kritische Entscheidungen, die getroffen werden müssen, um z.B. ein klinisches Problem zu lösen. Sie fokussieren dazu auf Schwierigkeiten, die häufig in der Praxis anzutreffen sind und legen ihren Schwerpunkt auf das Erkennen und den Umgang mit solchen Problemen. In ihrem Zentrum steht der Moment, an dem Prüflinge am wahrscheinlichsten Fehler machen. Entsprechend versuchen z.B. Mediziner, beim Erstellen zugehöriger Aufgaben ihre klinische Probleme auf solche kritischen Schritte zu reduzieren.

Key-Feature-Aufgaben bestehen aus der knappen Darstellung einer klinischen Situation (Stamm), gefolgt von 3-5 Fragen. Weil die Fragen stufenförmig aufeinander aufbauen, ist ein Zurückblättern zu den bereits gegebenen Antworten nicht mehr möglich. Auf diese Weise können korrekte Antworten in folgenden Fragen weiter verarbeitet werden, ohne dass diese Informationen die bereits gegebenen Antworten beeinflussen. Zur Entwicklung von Key-Feature-Aufgaben empfehlen [7] folgende Vorgehensweise:

- Definition eines Kontextes

- Wahl der klinischen Situation

- Identifikation der Key-Features des klinischen Problems

- Schreiben des klinischen Szenarios (Fallvignette)

- Schreiben der einzelnen Key-Feature-Fragen

- Auswahl des Antwortformates

- Bewertungsverfahren

- Inhaltsvalidierung

Schaper et al. beschreiben in [8] und [9] für das Einsatzgebiet Tiermedizin, wie sie summative MC-Assessments um Key-Feature-Aufgaben ergänzt haben.

Offene Aufgaben

Offene Aufgaben verlangen vom Prüfling eine Reproduktionsleistung, bei der er sich i.d.R. nicht an vorgegebenen Antwortalternativen orientieren kann.

Freitextaufgabe

Freitext-Aufgaben bieten einen offenen Eingabebereich für textbasierte Antworten an. Sie sind "vornehmlich angebracht, um die eigenständige Strukturierung, Organisation, Integration und Bewertung des Wissens sowie das Finden und Darstellen kreativer Ideen anzuregen bzw. zu überprüfen." [10] Sie können das Lernen fördern, da sie ein tieferes Verständnis für die Auseinandersetzung mit komplexen Themen verlangen. Je offener die zugehörige Frage formuliert wurde, umso schwieriger gestaltet sich die Auswertung der gegebenen Antworten. Eine maschinelle Auswertung ist z.B. nur im Sinne eines Schlagwortabgleichs möglich, aber nicht zwingend sinnvoll.

Lückentextaufgabe

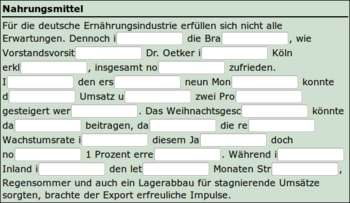

Die Lückentextaufgabe (auch Short-Answer-Aufgabe genannt) ermöglicht die freie Bearbeitung einer Aufgabenstellung mit einer kurzen, prägnanten Antwort. Dabei handelt es sich um ein Wort oder eine Zahl. Wesentlicher Vorteil ist, dass ein Raten von Antwortalternativen (wie es z.B. bei MC-Aufgaben möglich ist) entfällt. Nachteil hingegen ist, dass sich eine fehlerhafte Schreibweise negativ auf die automatisierte Bewertung auswirken kann. Manche Systeme gestatten daher die Angabe einer gewissen Toleranz, um korrekte Antworten trotz Flüchtigkeits- oder Rechtschreibfehlern erkennen zu können.

Die sog. Levenshtein-Distanz gibt z.B. die Zahl an Einfüge-, Lösch- und Ersetz-Operationen an, um eine eingegebene Zeichenkette in eine Vorgegebene zu überführen. Bei numerischen Aufgaben kann eine Fehlertoleranz in Form eines Wertebereichs eingestellt werden -- immer natürlich unter der Bedingung, dass die zugrunde liegende Technologie dies unterstützt.

Lückentexte bestehen aus mehreren solcher Short-Answer-Aufgaben. Beispiele für ihren Einsatz finden sich z.B. hier. Sie werden gerne von Sprachzentren für C-Tests zur Einstufung verwendet, um die Sprachfähigkeit von Prüflingen einzuschätzen. Weil sie korrekte Antworten vorgeben, sind sie wie geschlossene Aufgaben i.d.R. vollständig automatisiert und damit effizient auswertbar. [11]

Numerische Aufgabe

Numerische Aufgaben beziehen sich auf die Eingabe von Zahlenwerten. Dazu beinhaltet die Aufgabenstellung zumeist verschiedene Grundwerte, aus denen Prüflinge dann ihr Ergebnis errechnen sollen. Zu berücksichtigen sind dabei:

- Zielbereich: Viele Technologien gestatten die Angabe eines Zielbereichs, in dem die Eingaben der Prüflinge liegen müssen, damit die Aufgabe als korrekt gelöst gilt. Dies erleichtert die Auswertung und berücksichtigt etwaige Rundungsfehler.

- Formel: Wurde eine entsprechende mathematische Formel zur Berechnung des Ergebnisses hinterlegt, kann das auswertende System das korrekte Ergebnis in Echtzeit ermitteln und mit der Eingabe des Prüflings vergleichen.

- Zufallswerte: In manchen Fällen (z.B. für gemeinsames Lernen oder Erschweren von Täuschungsversuchen) soll jeder Prüfling eine individuelle Aufgabe erhalten. Besonders in den mathematisch-naturwissenschaftlichen Fächern bietet sich an, die Grundwerte einer solchen Aufgabe per Zufall bestimmen zu lassen. Ist zudem eine entsprechende Berechnungsformel hinterlegt, kann das System die Korrektheit einer Lösung autonom überprüfen.

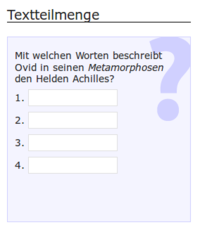

Textteilmengenaufgabe/Text-Box-Aufgabe

Bei der Textteilmengenaufgabe handelt es sich um eine Spezialisierung der Lückentextaufgabe. Prüflinge geben eine geforderte Zahl von Begriffen ein, die mit einer größeren Menge korrekter Vorgaben abgeglichen werden. Vorteil gegenüber der Lückentextaufgabe ist, dass Prüflinge durch Mehrfachangabe einer einzelnen Antwort keine weiteren Punkte erhalten.

Eine weitere Spezialisierung des Lückentexts ist die Text-Box-Aufgabe. Hier finden sich statt Freitextlücken Drop-Down-Boxen mit einer größeren Auswahl an Begriffen. Prüflinge müssen den korrekten Begriff auswählen und damit die Lücke schließen. Dieser Aufgabentyp ist also eine Kombination aus Lückentextaufgabe und der weiter oben beschriebenen Single-Choice-Aufgabe, nur dass hierbei eine große Zahl an Auswahlalternativen (Stichwort Wörterbuch) existiert.

Sonstige Aufgaben

Über die beschriebenen Typen von Aufgaben hinaus gibt es weitere Möglichkeiten, um die multimedialen Mehrwerte elektronischer Verfahren zu nutzen und in einer Prüfung z.B. größere Praxisnähe herzustellen. Nachfolgend sind einige zu dem Zweck eingesetzte Aufgabentypen exemplarisch aufgeführt.

Java-Applet-Aufgabe/Flash-Aufgabe

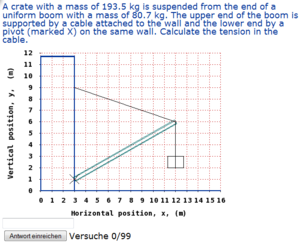

Bei diesem Typ handelt es sich um eine generische Schnittstelle für Java- oder Flash-Anwendungen. Diese können beliebige Inhalte haben und fungieren wie eine E-Prüfung innerhalb einer E-Prüfung. Über die Schnittstelle liefert die Anwendung nach Eingabe zurück, ob die Aufgabe korrekt gelöst wurde. Weil diese Form frei in Gestaltung und Programmierung ist, schafft sie Eingabemöglichkeiten, die von anderen Aufgabentypen bisher nicht vorgesehen sind. So ist z.B. ein Koordinatensystem darstellbar, in dem ein Prüfling geometrische Konstrukte anordnen oder Funktionen einzeichnen kann.

Datei-Upload

Der Aufgabentyp Datei-Upload erlaubt die Einreichung klassischer Ausarbeitungen wie Haus- oder Seminararbeiten, insofern diese in elektronischem Format (z.B. als PDF) vorliegen. Obwohl eine manuelle Begutachtung der Inhalte notwendig ist, können Prüfungstechnologien dabei helfen sicherzustellen, dass Beiträge fristgerecht eingereicht wurden.

Handelt es sich bei den hochgeladenen Dateien allerdings um Quellcodes von Programmen, wie sie z.B. bei Programmierkursen anfallen, kann das Prüfungssystem eine Begutachtung unterstützen. In diesem Fall sind z.B. Untersuchung auf syntaktische Korrektheit, Analyse der Programmstruktur (wurden Kommentare oder bestimmte Schleifentypen verwendet) oder ein Abgleich erwarteter Ausgabewerte bei vorgegebenen bzw. zufälligen Eingabewerten automatisiert vorstellbar.

Mündliche Antwort

Sieht ein Prüfungssystem eine mündliche Antwort bei einer Aufgabe vor, müssen die Prüflinge ihre Antworten mit dem Mikrofon aufzeichnen. Zu dem Zweck stellt ihnen das System eine entsprechende Schaltfläche bereit. Wie bei einer mündlichen Prüfung üblich spricht der Prüfling seine Antwort in einem vorab festgelegten Zeitraum ins Mikrofon. Da automatisierte Auswertung bislang nicht möglich ist, müssen Prüfende im Nachhinein sämtliche Aufzeichnungen anhören. Gegenüber schriftlicher Antworten bietet das aber die Möglichkeit, neben inhaltlichen und Verständnis-Aspekten auch auf korrekte Aussprache, Betonung oder Sprachgefühl zu achten. Entsprechend liegt der Hauptanwendungsbereich dieses Aufgabentyps bei Sprachzentren.

Erweiterung eines Systems um weitere Aufgabentypen

Viele E-Assessment-Systeme erlauben mittlerweile eine Erweiterung der angebotenen Aufgabentypen per Plugin. Es folgt eine Übersicht über die aktuell (23.11.2015) angebotenen Plugins für das LMS Moodle sowie das LMS Ilias.

Moodle-Plugins (Quelle)

- Drag and drop onto image

- Drag and drop into text

- Select missing words

- Ordering

- Drag and drop markers

- Drag-and-Drop Matching

- Gapfill Question

- Combined

- Concept Map Question Type

- OU multiple response

- Correct writing

- Formulas question type

- PoodLL Recording

- All-or-Nothing Multiple Choice

- STACK

- Music Theory

- Pattern match

- Algebra

- GeoGebra

- Variable numeric set

- Variable numeric set with units

- Regular expression short answer

- Multinumerical

- Java Molecular Editor

- Select Atoms or Molecules (MarvinJS)

- Name to Structure or Reaction (MarvinJS)

- Electron Pushing / Curved Arrow (MarvinJS)

- Opaque

- Variable numeric

- Reverse pattern match

- Spreadsheet

- Perl-Compatible Regular Expression

- POAS abstract question

- Pattern match with molecular editor

- Lewis Structures

- Freehand Drawing

- Music Key Signature

- Set splitting question

- vmatching

- Programmed responses

- javaunittest

- Structure match with editor

- Name to Structure or Reaction

- Electron Pushing / Curved Arrow

- Drag and Drop Organic Chemistry Nomenclature

- Fischer Projections

- Newman Projections

- Select Atoms or Molecules

- 2D/3D Structure Display Short Answer

- Music Scale

- Music Interval

- Calculated Objects

- Matrix question

- UB Hot Spots

Ilias-Plugins (Quelle)

- STACK-Question

- Accounting-Question

- Mathematik Online Plugin

- Formula Question (Formelfrage)

- Mobile Quiz

Auswahl des Aufgabentyps

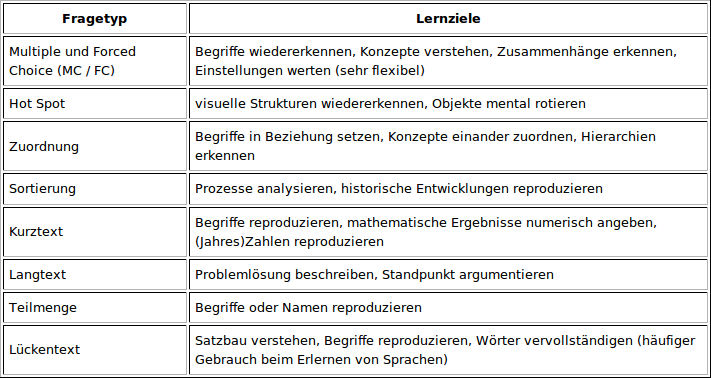

Hilfe bei der Zuordnung von Aufgabentypen zu Lernzielen gibt das E-Klausur-Wiki der Uni Gießen, aus dem die folgende Tabelle stammt:

Siehe zur Auswahl eines passenden Aufgabentyps auch den Abschnitt Aufgabentyp auswählen im Bereich Didaktik. Weitere Informationen zu Kompetenzerfassung, u.a. mit einer Gegenüberstellung verschiedener Antwortformate für Kompetenztests, ist z.B. bei Hartig und Klieme[12] zu finden.

Verwandte Themen

- Erstellen von Prüfungsaufgaben, insbesondere MC-Fragen

- Weiterführende Literatur

- Funktionsumfang ausgewählter E-Prüfungssysteme

Literaturnachweise

- ↑ Jona Florian Stieler: Validität summativer Prüfungen - Überlegungen zur Gestaltung von Klausuren, ISBN: 3-938076-36-4, Janus Presse, Bielefeld, 2011, Download als PDF

- ↑ Susan M. Case, David B. Swanson: Constructing Written Test Questions For the Basic and Clinical Sciences, 3. Auflage, National Board of Medical Examiners, 1998, Download als PDF

- ↑ Bernhard Jacobs: [1]. Abgerufen am 25.09.2012.

- ↑ David Foster, Harold L. Miller: A new format for multiple-choice testing: Discrete-Option Multiple-Choice. Results from early studies, in Psychology Science Quarterly, Volume 51, 2009 (4), S. 355-369, Download als PDF

- ↑ David Foster: Compelling Test Design Technology: Discrete Option Multiple Choice, White Paper, 2014, Artikel als PDF

- ↑ George E. Miller: The Assessment of Clinical Skills/Competence/Performance, in Academic Medicine, Ausgabe 65 (9), S. 63-67, 1990, Download als PDF

- ↑ 7,0 7,1 Veronika Kopp, Andreas Möltner, Martin R. Fischer: Key-Feature-Probleme zum Prüfen von prozeduralem Wissen: Ein Praxisleitfaden, in: GMS Zeitschrift für Medizinische Ausbildung, ISSN 1860-3572, 23(3), 2006, Artikel als PDF (Abgerufen am 23.11.2010)

- ↑ Elisabeth Schaper, Martin R. Fischer, Andrea Tipold, Jan P. Ehlers: Fallbasiertes, elektronisches Lernen und Prüfen in der Tiermedizin - auf der Suche nach einer realisierbaren Alternative zu Multiple-Choice-Prüfungen, in: Tierärztliche Umschau 66, S. 261-268, 2011

- ↑ Elisabeth Schaper, Andrea Tipold, Jan P. Ehlers: Use of key feature questions in summative assessment of veterinary medicine students, in: Irish Veterinary Journal, 66 (3), 2013, Artikel im Volltext

- ↑ Bernhard Jacobs: Ratschläge zur Konstruktion von Essay-Test-Aufgaben. Abgerufen am 20.03.2010.

- ↑ Bernhard Jacobs: Ratschläge zur Konstruktion von Short-Answer-Aufgaben. Abgerufen am 19.03.2010.

- ↑ Johannes Hartig, Eckhard Klieme: Möglichkeiten und Voraussetzungen technologiebasierter Kompetenzdiagnostik, Expertise im Auftrag des BMBF, Bildungsforschung Band 20, Bonn/Berlin, 2007, Download als PDF, Abgerufen am 21.06.2010