Didaktik: Unterschied zwischen den Versionen

K |

|||

| Zeile 1: | Zeile 1: | ||

| − | == | + | == Einsatzentscheidungen == |

| − | * | + | === Auswahl des passenden Szenarios === |

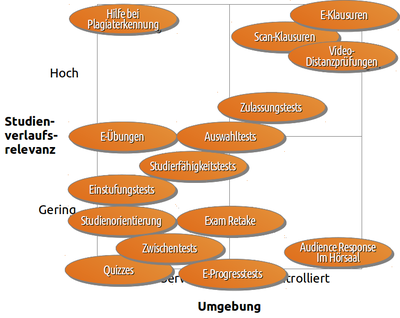

| − | ** | + | [[Datei:Einsatzszenarien.png|thumb|400px|Denkbare Einsatzszenarien von E-Prüfungen mit Einordnung nach "Gefährlichkeit", d.h. Relevanz für den weiteren Studienverlauf]] |

| − | + | Zunächst sind Zweck und Ziele einer elektronischen Prüfung zu bestimmen. Denkbare Einsatzgebiete sind z.B. (nicht vollständig): | |

| − | + | * Orientierung geben und die Vorlieben der Lernenden abfragen, um so mögliche Alternativen aufzeigen zu können? <br />(siehe z.B. [[Online Self Assessments zur Studienorientierung]]) | |

| − | * | + | * Motivieren, Studierende sollen sich noch einmal spielerisch mit den Inhalten auseinandersetzen und diese freiwillig wiederholen können, z.B. im Sinne eines Quiz im Anschluss an eine Lerneinheit oder Veranstaltung oder um verschiedene Wege/Kanäle nutzen, um die Lernenden zu erreichen, so dass diese sich ihren Vorlieben entsprechend mit den Inhalten beschäftigen können <br />(siehe z.B. [[Freiwillige Quizzes zur Wiederholung/Vertiefung]]) |

| − | * | + | * Wiederholung und Vertiefung der im Rahmen einer Veranstaltung gelernten Inhalte im Sinne einer Übung <br />(siehe z.B. [[Regelmäßige Aufgaben im Übungsbetrieb]]) |

| − | * | + | * Feststellen, ob bisher gelerntes Wissens ausreicht, um sich mit weiterführenden Inhalten beschäftigen zu können, z.B. als Zwischentest bei reinen E-Learning-Einheiten <br />(siehe z.B. [[Selbstlerneinheiten mit Zwischenstandskontrollen]]) |

| − | * | + | * Prüfen, ob die Voraussetzungen für den Besuch eines Studiengangs oder einer Lerneinheit gegeben sind <br />(siehe z.B. [[Zulassungstests zu Studiengängen oder Modulen]]) |

| − | + | * Leistungsbeurteilung zur Bewertung und Benotung z.B. als Abschlussprüfung einer Veranstaltung <br />(siehe z.B. [[Benotete elektronische Klausuren]]) | |

| + | |||

| + | Ist die Entscheidung für ein bestimmtes Szenario gefallen, ist im nächsten Schritt eine geeignete Metapher zu bestimmen, welche die Verwendung elektronischer Verfahren erleichtert. Soll z.B. eine bereits schriftlich vorliegende Version lediglich "elektronisiert" werden, damit diese die Lernenden auch auf anderen Kanälen als bisher erreichen kann? Oder sollen ganz neue Wege gegangen werden, die z.B. multimediale Elemente einbeziehen, die in der traditionellen schriftlichen Form nicht einbezogen werden konnten? | ||

| + | |||

| + | Eine detaillierte Beschreibung verschiedener Möglichkeiten mit zugehörigen Praxisbeispielen findet sich in der [[Einsatzszenarien|Übersicht über verschiedene Einsatzszenarien]]. Eine Übersicht über die Experten zu den einzelnen Szenarien und dafür eingesetzte Technologien findet sich in der [[Kompetenzmatrix]]. | ||

| + | |||

| + | |||

| + | === Bestimmung der Professionalisierungsebene === | ||

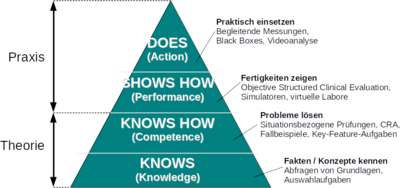

| + | [[Bild:Professionalisierungsgrad.png|thumb|400px|Professionalisierungebenen in Anlehnung an <ref name="miller" />]] | ||

| + | Miller<ref name="miller">George E. Miller: ''The Assessment of Clinical Skills/Competence/Performance'', in Academic Medicine, Ausgabe 65 (9), S. 63-67, 1990, [http://journals.lww.com/academicmedicine/Abstract/1990/09000/The_assessment_of_clinical.45.aspx Download als PDF] (Abgerufen am 14.06.2010)</ref> identifiziert vier Ebenen (proficiency levels), die Lernende beim Aufbau von Fertigkeiten durchlaufen. Diese Ebenen bauen jeweils aufeinander auf und repräsentieren den Grad der Professionalisierung eines Lernenden auf dem Weg vom Anfänger zum Experten. Während die unteren Ebenen den Erkenntnisgewinn (Cognition) beschreiben, repräsentieren die darüber liegenden Ebenen dessen Umsetzung in die Praxis (Behaviour). Die elektronische Leistungsmessung richtet sich nach dem Grad der Professionalisierung und muss daher an die jeweilige Ebene angepasst sein. | ||

| + | * '''Knowledge (Wissen)''': Grundlage der Professionalisierung ist das Wissen um Fakten und Konzepte. Um deren Verständnis abzufragen, verwenden zugehörige Messungen z.B. Multiple-Choice-Aufgaben. Ein Beispiel ist das Konzept „Rechts vor Links“, dessen Grundlagen bei der Führerscheinprüfung behandelt werden. | ||

| + | * '''Competence (Problemlösung)''': Im darauf aufbauenden Schritt kann ein Lernender das vorhandene Faktenwissen zur Problemlösung einsetzen. In diesem Fall sind situationsbezogene Prüfungen oder Fallbeispiele sinnvoll, die eine angemessene Anwendung bereits gelernter Fakten überprüfen können. Beispiel aus der Führerscheinprüfung ist die Darstellung einer Verkehrssituation mit der Frage, was in diesem Fall zu tun ist. | ||

| + | * '''Performance (Fertigkeiten)''': Die folgende Ebene umfasst praktische Fertigkeiten eines Lernenden; sie verlässt den reinen Erkenntnisbereich und bezieht sich auf erlerntes Verhalten. Hier geht es darum, Handlungsweisen nicht nur zu beschreiben oder verstanden zu haben, sondern diese gezielt erbringen zu können. Möglichkeiten, um das elektronisch zu überprüfen, bieten z.B. virtuelle Labore oder Simulatoren. So könnte man bei der Führerscheinprüfung z.B. einen Fahrsimulator einsetzen, um die Fahrtüchtigkeit der Prüflinge zu erproben.. | ||

| + | * '''Action (Können)''': Als Experte wendet der Lernende schließlich Wissen, Problemlösekompetenz und Fertigkeiten in der Praxis an. Durch Beobachtung und Aufzeichnung kann dieses Verhalten bestimmt und analysiert werden. Beispiele sind Fahrtenschreiber in Fahrzeugen, Black Boxes in Flugzeugen oder die Videoanalyse von Bewegungsabläufen bei Sportlern, um Optimierungspotential aufzudecken. | ||

| − | + | Reine Wissensprüfungen bergen die Gefahr, dass man Prüflingen aufgrund ihres Wissens (träges Wissen) fälschlicherweise Können zuschreibt bzw. umgekehrt vermutet, dass wenn bestimmtes Wissen (implizites Wissen) fehlt, auch zugehöriges Können nicht vorhanden ist. <ref>Georg Hans Neuweg: ''Das Können prüfen - Plädoyer für eine andere Prüfungsdidaktik'', in: ''GdWZ - Grundlagen der Weiterbildung'', Ausgabe 12 (2001) 5, S. 202-205, [http://www.hum.tsn.at/cms/upload/pdf/Neuweg(2001).pdf Download als PDF] (Abgerufen am 27.05.2010)</ref> Bei einer idealen Prüfung wählt der Prüfende daher einen Prüfungstyp, der dem jeweiligen Professionalisierungsgrad entspricht. Für Hochschulen bedeutet dies, dass die Möglichkeiten für den Einsatz elektronischer Prüfungen davon abhängen, wie praxisorientiert sie ausbildet. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | === | + | === Ablauf festlegen === |

| − | * | + | * siehe [[Organisation und Durchführung]] |

| − | |||

| − | |||

| − | === | + | === Geeignete Technologien aussuchen === |

| − | + | * siehe [[Technik und Systeme]] | |

== Aufgabenformate/Prüfungsitems == | == Aufgabenformate/Prüfungsitems == | ||

* [[Fragetypen | Verschiedene Fragetypen]] | * [[Fragetypen | Verschiedene Fragetypen]] | ||

| − | + | === Typen von Antwortwahlaufgaben === | |

Beispiele für die verschiedenen Aufgabetypen sind u.a. in Appendix A von Susan M. Case, David B. Swanson: ''Constructing Written Test Questions For the Basic and Clinical Sciences'' ([http://www.nbme.org/PDF/ItemWriting_2003/2003IWGwhole.pdf Download als PDF]) zu finden. | Beispiele für die verschiedenen Aufgabetypen sind u.a. in Appendix A von Susan M. Case, David B. Swanson: ''Constructing Written Test Questions For the Basic and Clinical Sciences'' ([http://www.nbme.org/PDF/ItemWriting_2003/2003IWGwhole.pdf Download als PDF]) zu finden. | ||

| Zeile 74: | Zeile 67: | ||

|} | |} | ||

| − | == Erstellen von Prüfungsfragen (insbesondere Multiple-Choice) == | + | === Erstellen von Prüfungsfragen (insbesondere Multiple-Choice) === |

MC-Fragen dienen der Wissensüberprüfung. Hinweise für die Erstellung entsprechender Fragen liefern die folgenden Literaturempfehlungen: | MC-Fragen dienen der Wissensüberprüfung. Hinweise für die Erstellung entsprechender Fragen liefern die folgenden Literaturempfehlungen: | ||

* Thomas M. Haladyna, Steven M. Downing, Michael C. Rodriguez: ''A Review of Multiple-Choice Item-Writing Guidelines for Classroom Assessment'', in: Applied Measurement in Education, 15(3), 2002, S. 309–334, [http://www.uam.es/personal_pdi/psicologia/fjabad/PSICOMETRIA/MATERIALES/haladyna_Guidelines_AME_2002.pdf Download als PDF] | * Thomas M. Haladyna, Steven M. Downing, Michael C. Rodriguez: ''A Review of Multiple-Choice Item-Writing Guidelines for Classroom Assessment'', in: Applied Measurement in Education, 15(3), 2002, S. 309–334, [http://www.uam.es/personal_pdi/psicologia/fjabad/PSICOMETRIA/MATERIALES/haladyna_Guidelines_AME_2002.pdf Download als PDF] | ||

| Zeile 83: | Zeile 76: | ||

* René Krebs: ''Anleitung zur Herstellung von MC-Fragen und MC-Prüfungen für die ärztliche Ausbildung'', Bern, 2004, [http://www.i-med.ac.at/lehre/habil/mc_anleitung.pdf Download als PDF] | * René Krebs: ''Anleitung zur Herstellung von MC-Fragen und MC-Prüfungen für die ärztliche Ausbildung'', Bern, 2004, [http://www.i-med.ac.at/lehre/habil/mc_anleitung.pdf Download als PDF] | ||

* Michael C. Rodriguez: ''Three Options Are Optimal for Multiple-Choice Items: A Meta-Analysis of 80 Years of Research'', 2005, [http://onlinelibrary.wiley.com/resolve/doi?DOI=10.1111/j.1745-3992.2005.00006.x Download als PDF] | * Michael C. Rodriguez: ''Three Options Are Optimal for Multiple-Choice Items: A Meta-Analysis of 80 Years of Research'', 2005, [http://onlinelibrary.wiley.com/resolve/doi?DOI=10.1111/j.1745-3992.2005.00006.x Download als PDF] | ||

| + | |||

| + | == Qualitätssicherung == | ||

| + | === Gütekriterien eines Tests === | ||

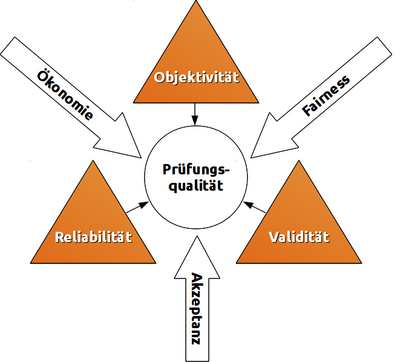

| + | [[Datei:Spannungsfeld.png|thumb|right|400px|Gütekriterien elektronischer Prüfungen]] | ||

| + | Lienert & Raatz<ref>Gustav A. Lienert, Ulrich Raatz: ''Testaufbau und Testanalyse'', 6. Auflage, ISBN-13: 978-3621274241, BeltzPVU, 1998, [http://books.google.de/books?id=-ZL_Ouwv8XsC bei Google Books]</ref> sowie Amelang & Schmidt-Atzert<ref>Manfred Amelang, Lothar Schmidt-Atzert: ''Psychologische Diagnostik und Intervention'', 4. Auflage, ISBN-13: 978-3540284628, Springer, Berlin, 2006, [http://books.google.de/books?id=radwVjEBO4YC bei Google Books]</ref> identifizieren verschiedene Gütekriterien eines Tests. Stieler<ref>Jona Florian Stieler: ''Validität summativer Prüfungen - Überlegungen zur Gestaltung von Klausuren'', ISBN: 3-938076-36-4, Janus Presse, Bielefeld, 2011, [http://duepublico.uni-duisburg-essen.de/servlets/DerivateServlet/Derivate-25877/Validitaet_Gesamt.pdf Download als PDF]</ref> untersucht diese Kriterien für den pädagogischen Bereich, insbesondere zur Gestaltung von Klausuren. | ||

| + | |||

| + | ==== Hauptgütekriterien ==== | ||

| + | Bauen aufeinander auf, wobei jede Stufe ist nur nach Erfüllung der vorhergehenden zu erreichen ist. | ||

| + | * '''Objektivität''': Unabhängigkeit vom Untersucher; verschiedene Prüfer kommen bei gleichen Prüflingen zum gleichen Ergebnis. | ||

| + | ** bei Durchführung der Prüfung (Durchführungsobjektivität) | ||

| + | ** bei Auswertung der Antworten (Auswertungsobjektivität) | ||

| + | ** bei Interpretation der Ergebnisse (Interpretationsobjektivität) | ||

| + | * '''Reliabilität''': Grad der Messgenauigkeit; Wiederholungen erbringen bei gleichen Beteiligten gleiche Ergebnisse. | ||

| + | ** durch Paralleltests: streng vergleichbare Tests wiederholen | ||

| + | ** durch Retests: gleichen Test wiederholen | ||

| + | ** innere Konsistenz: messbar z.B. als [http://de.wikipedia.org/wiki/Cronbachs_Alpha Cronbachs Alpha] | ||

| + | *** durch Testhalbierung: Test in gleichwertige Hälften teilen und als 2 eigene Tests auswerten (siehe Paralleltest) | ||

| + | *** durch Konsistenzanalyse: Ermittlung der Reliabilität auf indirektem Weg über Aufgabenschwierigkeit und Trennschärfe | ||

| + | * '''Validität''': Ergebnisse des Tests korrelieren mit den zu prüfenden Kompetenzen. | ||

| + | ** Inhaltsvalidität: Test prüft Wissen/Kompetenzen/Leistung, die mit Lehrzielen übereinstimmen. | ||

| + | ** Konstruktvalidität Test ist geeignet, inhaltliche Kompetenzen zu erfassen (und nicht z.B. die Fähigkeit des Prüflings, Gedanken in kurzer Zeit aufzuschreiben/einzugeben). | ||

| + | ** Kriteriumsvalidität: Testergebnisse stimmen mit empirischem Kriterium überein, das bereits vorliegt (konkurrente Validität, z.B. Schulnoten) oder erst später erkennbar wird (prognostische Validität, z.B. Studienerfolg). | ||

| + | |||

| + | ==== Nebengütekriterien ==== | ||

| + | * '''Akzeptanz''': Test ist für Prüflinge transparent; keine Normen werden verletzt. | ||

| + | * '''Ökonomie''': Nutzen übersteigt Kosten. | ||

| + | * '''Chancengerechtigkeit/Fairness''': Gleiche Voraussetzungen für alle. | ||

| + | |||

| + | ==== Kriterien im Spannungsfeld ==== | ||

| + | Die genannten Kriterien können sich gegenseitig beeinflussen. Ein Beispiel: setzt man genügend Mittel und Zeit ein (Ökonomie), ist es möglich, eine Prüfung sehr objektiv, reliabel und valide zu gestalten. Das erhöht ebenso die Akzeptanz unter den Prüflingen. Sind hingegen hohe Reliabilität und Akzeptanz nicht wichtig, ist eine auch mit geringerem Mitteleinsatz möglich. Diese Faktoren sind jeweils im Einzelfall abzuwägen. | ||

| + | |||

| + | == Noch auszuarbeitende Themen == | ||

| + | * Auswahl geeigeneter Aufgabenformate/Prüfungsitems | ||

| + | ** Einsatzmöglichkeiten z.B. im Rahmen von "inquiry-based learning" (z.B. http://www.pi-project.ac.uk/) | ||

| + | * Frageerstellung nach didaktischen Gesichtspunkten | ||

| + | * Aufbau bzw. Einbeziehung fachlicher Fragepools | ||

| + | * Feststellen des Schwierigkeitsgrads der erstellten Aufgaben | ||

| + | * Festlegen des Prüfungsverlaufs (statisch, adaptiv, stufenförmig) | ||

| + | * Prüfungserstellung und Ablaufplanung | ||

| + | * Prüfungsvorbereitung, Durchführung Übungsklausuren | ||

| + | * Statistische Auswertung der Ergebnisse, Itemanalyse | ||

== Literaturnachweise == | == Literaturnachweise == | ||

Version vom 17. Februar 2011, 07:36 Uhr

Inhaltsverzeichnis

Einsatzentscheidungen

Auswahl des passenden Szenarios

Zunächst sind Zweck und Ziele einer elektronischen Prüfung zu bestimmen. Denkbare Einsatzgebiete sind z.B. (nicht vollständig):

- Orientierung geben und die Vorlieben der Lernenden abfragen, um so mögliche Alternativen aufzeigen zu können?

(siehe z.B. Online Self Assessments zur Studienorientierung) - Motivieren, Studierende sollen sich noch einmal spielerisch mit den Inhalten auseinandersetzen und diese freiwillig wiederholen können, z.B. im Sinne eines Quiz im Anschluss an eine Lerneinheit oder Veranstaltung oder um verschiedene Wege/Kanäle nutzen, um die Lernenden zu erreichen, so dass diese sich ihren Vorlieben entsprechend mit den Inhalten beschäftigen können

(siehe z.B. Freiwillige Quizzes zur Wiederholung/Vertiefung) - Wiederholung und Vertiefung der im Rahmen einer Veranstaltung gelernten Inhalte im Sinne einer Übung

(siehe z.B. Regelmäßige Aufgaben im Übungsbetrieb) - Feststellen, ob bisher gelerntes Wissens ausreicht, um sich mit weiterführenden Inhalten beschäftigen zu können, z.B. als Zwischentest bei reinen E-Learning-Einheiten

(siehe z.B. Selbstlerneinheiten mit Zwischenstandskontrollen) - Prüfen, ob die Voraussetzungen für den Besuch eines Studiengangs oder einer Lerneinheit gegeben sind

(siehe z.B. Zulassungstests zu Studiengängen oder Modulen) - Leistungsbeurteilung zur Bewertung und Benotung z.B. als Abschlussprüfung einer Veranstaltung

(siehe z.B. Benotete elektronische Klausuren)

Ist die Entscheidung für ein bestimmtes Szenario gefallen, ist im nächsten Schritt eine geeignete Metapher zu bestimmen, welche die Verwendung elektronischer Verfahren erleichtert. Soll z.B. eine bereits schriftlich vorliegende Version lediglich "elektronisiert" werden, damit diese die Lernenden auch auf anderen Kanälen als bisher erreichen kann? Oder sollen ganz neue Wege gegangen werden, die z.B. multimediale Elemente einbeziehen, die in der traditionellen schriftlichen Form nicht einbezogen werden konnten?

Eine detaillierte Beschreibung verschiedener Möglichkeiten mit zugehörigen Praxisbeispielen findet sich in der Übersicht über verschiedene Einsatzszenarien. Eine Übersicht über die Experten zu den einzelnen Szenarien und dafür eingesetzte Technologien findet sich in der Kompetenzmatrix.

Bestimmung der Professionalisierungsebene

Miller[1] identifiziert vier Ebenen (proficiency levels), die Lernende beim Aufbau von Fertigkeiten durchlaufen. Diese Ebenen bauen jeweils aufeinander auf und repräsentieren den Grad der Professionalisierung eines Lernenden auf dem Weg vom Anfänger zum Experten. Während die unteren Ebenen den Erkenntnisgewinn (Cognition) beschreiben, repräsentieren die darüber liegenden Ebenen dessen Umsetzung in die Praxis (Behaviour). Die elektronische Leistungsmessung richtet sich nach dem Grad der Professionalisierung und muss daher an die jeweilige Ebene angepasst sein.

- Knowledge (Wissen): Grundlage der Professionalisierung ist das Wissen um Fakten und Konzepte. Um deren Verständnis abzufragen, verwenden zugehörige Messungen z.B. Multiple-Choice-Aufgaben. Ein Beispiel ist das Konzept „Rechts vor Links“, dessen Grundlagen bei der Führerscheinprüfung behandelt werden.

- Competence (Problemlösung): Im darauf aufbauenden Schritt kann ein Lernender das vorhandene Faktenwissen zur Problemlösung einsetzen. In diesem Fall sind situationsbezogene Prüfungen oder Fallbeispiele sinnvoll, die eine angemessene Anwendung bereits gelernter Fakten überprüfen können. Beispiel aus der Führerscheinprüfung ist die Darstellung einer Verkehrssituation mit der Frage, was in diesem Fall zu tun ist.

- Performance (Fertigkeiten): Die folgende Ebene umfasst praktische Fertigkeiten eines Lernenden; sie verlässt den reinen Erkenntnisbereich und bezieht sich auf erlerntes Verhalten. Hier geht es darum, Handlungsweisen nicht nur zu beschreiben oder verstanden zu haben, sondern diese gezielt erbringen zu können. Möglichkeiten, um das elektronisch zu überprüfen, bieten z.B. virtuelle Labore oder Simulatoren. So könnte man bei der Führerscheinprüfung z.B. einen Fahrsimulator einsetzen, um die Fahrtüchtigkeit der Prüflinge zu erproben..

- Action (Können): Als Experte wendet der Lernende schließlich Wissen, Problemlösekompetenz und Fertigkeiten in der Praxis an. Durch Beobachtung und Aufzeichnung kann dieses Verhalten bestimmt und analysiert werden. Beispiele sind Fahrtenschreiber in Fahrzeugen, Black Boxes in Flugzeugen oder die Videoanalyse von Bewegungsabläufen bei Sportlern, um Optimierungspotential aufzudecken.

Reine Wissensprüfungen bergen die Gefahr, dass man Prüflingen aufgrund ihres Wissens (träges Wissen) fälschlicherweise Können zuschreibt bzw. umgekehrt vermutet, dass wenn bestimmtes Wissen (implizites Wissen) fehlt, auch zugehöriges Können nicht vorhanden ist. [2] Bei einer idealen Prüfung wählt der Prüfende daher einen Prüfungstyp, der dem jeweiligen Professionalisierungsgrad entspricht. Für Hochschulen bedeutet dies, dass die Möglichkeiten für den Einsatz elektronischer Prüfungen davon abhängen, wie praxisorientiert sie ausbildet.

Ablauf festlegen

Geeignete Technologien aussuchen

- siehe Technik und Systeme

Aufgabenformate/Prüfungsitems

Typen von Antwortwahlaufgaben

Beispiele für die verschiedenen Aufgabetypen sind u.a. in Appendix A von Susan M. Case, David B. Swanson: Constructing Written Test Questions For the Basic and Clinical Sciences (Download als PDF) zu finden.

| Typ | Name |

|---|---|

| A | Einfachauswahlaufgabe |

| B | Zuordnungsaufgabe |

| C | A/B/beide/keine-Aufgabe |

| D | komplexe Zuordnungsaufgabe |

| E | Verknüpfungsaufgabe |

| H | Vergleichsaufgabe |

| I | Abhängigkeitsaufgabe |

| K | komplexe Richtig/Falsch‐Aufgabe |

| K' | Kombinationsaufgabe |

| R | erweiterte Zuordnungsaufgabe |

| X | einfache Richtig/Falsch‐Aufgabe |

| Pick N | Mehrfachauswahlaufgabe |

Erstellen von Prüfungsfragen (insbesondere Multiple-Choice)

MC-Fragen dienen der Wissensüberprüfung. Hinweise für die Erstellung entsprechender Fragen liefern die folgenden Literaturempfehlungen:

- Thomas M. Haladyna, Steven M. Downing, Michael C. Rodriguez: A Review of Multiple-Choice Item-Writing Guidelines for Classroom Assessment, in: Applied Measurement in Education, 15(3), 2002, S. 309–334, Download als PDF

- Thomas M. Haladyna: Developing and Validating Multiple-Choice Test Items, 3. Auflage, ISBN-13: 978-0805846614, Routledge, 2004

- Katrin Brauns, Sebastian Schubert: Qualitätssicherung von Multiple-Choice-Prüfungen, in Sigrid Dany, Birgit Szczyrba, Johannes Wildt (Hrsg.): Prüfungen auf die Agenda! Hochschuldidaktische Perspektiven auf Reformen im Hochschulwesen, S. 92-102, ISBN-13: 978-3763935710, Bertelsmann, Bielefeld, 2008 (Blickpunkt Hochschuldidaktik, Band 118)

- Susan M. Case, David B. Swanson: Constructing Written Test Questions For the Basic and Clinical Sciences, 3. Auflage, National Board of Medical Examiners, 1998, Download als PDF

- Institut für Aus-, Weiter- und Fortbildung Medizinische Fakultät Universität Bern: Kompetent prüfen. Handbuch zur Planung, Durchführung und Auswertung von Facharztprüfungen, 1999, Download als PDF

- René Krebs: Anleitung zur Herstellung von MC-Fragen und MC-Prüfungen für die ärztliche Ausbildung, Bern, 2004, Download als PDF

- Michael C. Rodriguez: Three Options Are Optimal for Multiple-Choice Items: A Meta-Analysis of 80 Years of Research, 2005, Download als PDF

Qualitätssicherung

Gütekriterien eines Tests

Lienert & Raatz[3] sowie Amelang & Schmidt-Atzert[4] identifizieren verschiedene Gütekriterien eines Tests. Stieler[5] untersucht diese Kriterien für den pädagogischen Bereich, insbesondere zur Gestaltung von Klausuren.

Hauptgütekriterien

Bauen aufeinander auf, wobei jede Stufe ist nur nach Erfüllung der vorhergehenden zu erreichen ist.

- Objektivität: Unabhängigkeit vom Untersucher; verschiedene Prüfer kommen bei gleichen Prüflingen zum gleichen Ergebnis.

- bei Durchführung der Prüfung (Durchführungsobjektivität)

- bei Auswertung der Antworten (Auswertungsobjektivität)

- bei Interpretation der Ergebnisse (Interpretationsobjektivität)

- Reliabilität: Grad der Messgenauigkeit; Wiederholungen erbringen bei gleichen Beteiligten gleiche Ergebnisse.

- durch Paralleltests: streng vergleichbare Tests wiederholen

- durch Retests: gleichen Test wiederholen

- innere Konsistenz: messbar z.B. als Cronbachs Alpha

- durch Testhalbierung: Test in gleichwertige Hälften teilen und als 2 eigene Tests auswerten (siehe Paralleltest)

- durch Konsistenzanalyse: Ermittlung der Reliabilität auf indirektem Weg über Aufgabenschwierigkeit und Trennschärfe

- Validität: Ergebnisse des Tests korrelieren mit den zu prüfenden Kompetenzen.

- Inhaltsvalidität: Test prüft Wissen/Kompetenzen/Leistung, die mit Lehrzielen übereinstimmen.

- Konstruktvalidität Test ist geeignet, inhaltliche Kompetenzen zu erfassen (und nicht z.B. die Fähigkeit des Prüflings, Gedanken in kurzer Zeit aufzuschreiben/einzugeben).

- Kriteriumsvalidität: Testergebnisse stimmen mit empirischem Kriterium überein, das bereits vorliegt (konkurrente Validität, z.B. Schulnoten) oder erst später erkennbar wird (prognostische Validität, z.B. Studienerfolg).

Nebengütekriterien

- Akzeptanz: Test ist für Prüflinge transparent; keine Normen werden verletzt.

- Ökonomie: Nutzen übersteigt Kosten.

- Chancengerechtigkeit/Fairness: Gleiche Voraussetzungen für alle.

Kriterien im Spannungsfeld

Die genannten Kriterien können sich gegenseitig beeinflussen. Ein Beispiel: setzt man genügend Mittel und Zeit ein (Ökonomie), ist es möglich, eine Prüfung sehr objektiv, reliabel und valide zu gestalten. Das erhöht ebenso die Akzeptanz unter den Prüflingen. Sind hingegen hohe Reliabilität und Akzeptanz nicht wichtig, ist eine auch mit geringerem Mitteleinsatz möglich. Diese Faktoren sind jeweils im Einzelfall abzuwägen.

Noch auszuarbeitende Themen

- Auswahl geeigeneter Aufgabenformate/Prüfungsitems

- Einsatzmöglichkeiten z.B. im Rahmen von "inquiry-based learning" (z.B. http://www.pi-project.ac.uk/)

- Frageerstellung nach didaktischen Gesichtspunkten

- Aufbau bzw. Einbeziehung fachlicher Fragepools

- Feststellen des Schwierigkeitsgrads der erstellten Aufgaben

- Festlegen des Prüfungsverlaufs (statisch, adaptiv, stufenförmig)

- Prüfungserstellung und Ablaufplanung

- Prüfungsvorbereitung, Durchführung Übungsklausuren

- Statistische Auswertung der Ergebnisse, Itemanalyse

Literaturnachweise

- ↑ 1,0 1,1 George E. Miller: The Assessment of Clinical Skills/Competence/Performance, in Academic Medicine, Ausgabe 65 (9), S. 63-67, 1990, Download als PDF (Abgerufen am 14.06.2010)

- ↑ Georg Hans Neuweg: Das Können prüfen - Plädoyer für eine andere Prüfungsdidaktik, in: GdWZ - Grundlagen der Weiterbildung, Ausgabe 12 (2001) 5, S. 202-205, Download als PDF (Abgerufen am 27.05.2010)

- ↑ Gustav A. Lienert, Ulrich Raatz: Testaufbau und Testanalyse, 6. Auflage, ISBN-13: 978-3621274241, BeltzPVU, 1998, bei Google Books

- ↑ Manfred Amelang, Lothar Schmidt-Atzert: Psychologische Diagnostik und Intervention, 4. Auflage, ISBN-13: 978-3540284628, Springer, Berlin, 2006, bei Google Books

- ↑ Jona Florian Stieler: Validität summativer Prüfungen - Überlegungen zur Gestaltung von Klausuren, ISBN: 3-938076-36-4, Janus Presse, Bielefeld, 2011, Download als PDF