Prüfungsqualität: Unterschied zwischen den Versionen

(Die Seite wurde neu angelegt: „thumb|right|400px|Gütekriterien elektronischer Prüfungen Lienert & Raatz<ref>Gustav A. Lienert, Ulrich Raatz: ''Testaufbau und Testa…“) |

(kein Unterschied)

|

Version vom 29. März 2012, 06:47 Uhr

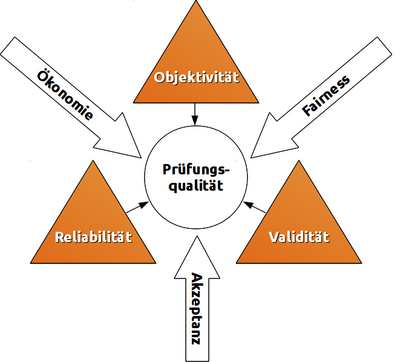

Lienert & Raatz[1] sowie Amelang & Schmidt-Atzert[2] identifizieren verschiedene Gütekriterien eines Tests. Stieler[3] untersucht diese Kriterien für den pädagogischen Bereich, insbesondere zur Gestaltung von Klausuren.

Inhaltsverzeichnis

Hauptgütekriterien

Bauen aufeinander auf, wobei jede Stufe ist nur nach Erfüllung der vorhergehenden zu erreichen ist.

- Objektivität: Unabhängigkeit vom Untersucher; verschiedene Prüfer kommen bei gleichen Prüflingen zum gleichen Ergebnis.

- bei Durchführung der Prüfung (Durchführungsobjektivität)

- bei Auswertung der Antworten (Auswertungsobjektivität)

- bei Interpretation der Ergebnisse (Interpretationsobjektivität)

- Reliabilität: Grad der Messgenauigkeit; Wiederholungen erbringen bei gleichen Beteiligten gleiche Ergebnisse.

- durch Paralleltests: streng vergleichbare Tests wiederholen

- durch Retests: gleichen Test wiederholen

- innere Konsistenz: messbar z.B. als Cronbachs Alpha

- durch Testhalbierung: Test in gleichwertige Hälften teilen und als 2 eigene Tests auswerten (siehe Paralleltest)

- durch Konsistenzanalyse: Ermittlung der Reliabilität auf indirektem Weg über Aufgabenschwierigkeit und Trennschärfe

- Validität: Ergebnisse des Tests korrelieren mit den zu prüfenden Kompetenzen.

- Inhaltsvalidität: Test prüft Wissen/Kompetenzen/Leistung, die mit Lehrzielen übereinstimmen.

- Konstruktvalidität Test ist geeignet, inhaltliche Kompetenzen zu erfassen (und nicht z.B. die Fähigkeit des Prüflings, Gedanken in kurzer Zeit aufzuschreiben/einzugeben).

- Kriteriumsvalidität: Testergebnisse stimmen mit empirischem Kriterium überein, das bereits vorliegt (konkurrente Validität, z.B. Schulnoten) oder erst später erkennbar wird (prognostische Validität, z.B. Studienerfolg).

Nebengütekriterien

- Akzeptanz: Test ist für Prüflinge transparent; keine Normen werden verletzt.

- Ökonomie: Nutzen übersteigt Kosten.

- Chancengerechtigkeit/Fairness: Gleiche Voraussetzungen für alle.

Spannungsfeld

Die genannten Kriterien können sich gegenseitig beeinflussen. Ein Beispiel: setzt man genügend Mittel und Zeit ein (Ökonomie), ist es möglich, eine Prüfung sehr objektiv, reliabel und valide zu gestalten. Das erhöht ebenso die Akzeptanz unter den Prüflingen. Sind hingegen hohe Reliabilität und Akzeptanz nicht wichtig, ist eine auch mit geringerem Mitteleinsatz möglich. Diese Faktoren sind jeweils im Einzelfall abzuwägen.

Itemanalyse

Itemanalyse bezeichnet die Verwendung statistischer Verfahren, um die Brauchbarkeit von Aufgaben (den sog. Items) zu beurteilen. Sie versucht deren Reliabilität zu erfassen und ist damit Voraussetzung, diese ggf. zu verbessern. Dies geschieht i.d.R. durch Analyse der Rohwertverteilung, Berechnung statistischer Kennwerte wie Itemschwierigkeit, Trennschärfe und Homogenität sowie durch Dimensionalitätsprüfung. Häufig wird die Itemanalyse mit Antworten einer Referenzgruppe durchgeführt, die der Zielgruppe (als Stichprobe) ähnlich ist.

- Rohwertverteilung: Durch grafische Darstellung der Ergebnisse besteht die Möglichkeit, die Verteilung mit der (gewünschten oder erwarteten) Normalverteilung zu vergleichen

- Itemschwierigkeit: Gibt das Verhältnis der Personen, die dieses Item richtig gelöst haben, zu sämtlichen Testteilnehmern an.

- Trennschärfe: Macht Aussagen über die Vorhersagbarkeit des Gesamtergebnisses aufgrund der Beantwortung des vorliegenden Items.

- Homogenität: Gibt an, wie sehr die unterschiedlichen Items eines Tests miteinander korrelieren, sowohl vom Inhalt als auch von ihrer Schwierigkeit.

- Dimensionalität: Beschreibt, ob ein Test nur ein Merkmal (eindimensionaler Test) oder mehrere Konstrukte bzw. Teil-Konstrukte erfasst (mehrdimensionaler Test).

Literatur

- ↑ Gustav A. Lienert, Ulrich Raatz: Testaufbau und Testanalyse, 6. Auflage, ISBN-13: 978-3621274241, BeltzPVU, 1998, bei Google Books

- ↑ Manfred Amelang, Lothar Schmidt-Atzert: Psychologische Diagnostik und Intervention, 4. Auflage, ISBN-13: 978-3540284628, Springer, Berlin, 2006, bei Google Books

- ↑ Jona Florian Stieler: Validität summativer Prüfungen - Überlegungen zur Gestaltung von Klausuren, ISBN: 3-938076-36-4, Janus Presse, Bielefeld, 2011, Download als PDF