E-Assessment: Unterschied zwischen den Versionen

(→Literatur) |

K (→Charakteristika elektronischer Assess ments) |

||

| Zeile 46: | Zeile 46: | ||

* System soll „Mitwachsen“ mit steigenden Anforderungen bzw. hochschul- und fachtypische Anforderungen erfüllen | * System soll „Mitwachsen“ mit steigenden Anforderungen bzw. hochschul- und fachtypische Anforderungen erfüllen | ||

| − | == Charakteristika elektronischer | + | == Charakteristika elektronischer Assessments == |

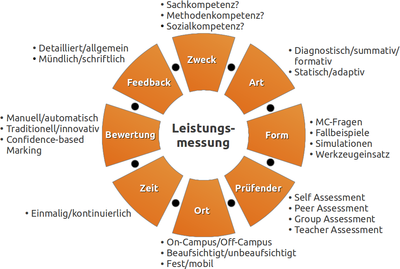

[[Bild:Charakteristika.png|thumb|400px|Charakteristika elektronischer Assessments]] | [[Bild:Charakteristika.png|thumb|400px|Charakteristika elektronischer Assessments]] | ||

Ein E-Assessment besteht aus unterschiedlichen Elementen und folgt verschiedenen Prinzipien. Lehrende können es - je nach Zielsetzung - so gestalten, dass es zu Veranstaltungstyp und Einsatzzweck passt. Die Abb. rechts zeigt Charakteristika, die ein E-Assessment ausmachen; ihre Beschreibung schließt sich an. | Ein E-Assessment besteht aus unterschiedlichen Elementen und folgt verschiedenen Prinzipien. Lehrende können es - je nach Zielsetzung - so gestalten, dass es zu Veranstaltungstyp und Einsatzzweck passt. Die Abb. rechts zeigt Charakteristika, die ein E-Assessment ausmachen; ihre Beschreibung schließt sich an. | ||

Version vom 14. Januar 2016, 10:44 Uhr

Inhaltsverzeichnis

Begriffsdiskussion

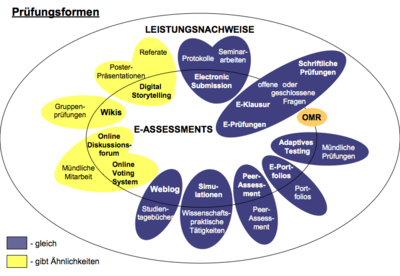

Ein elektronisches Assessment (E-Assessment) ist eine Prüfung, die mit Hilfe von Informations- und Kommunikationstechnologien (IKT) vorgenommen wird. Diese können bei der Aufgabenstellung, Leistungserbringung sowie Leistungsbeurteilung eingesetzt werden, beziehen sich also auf Vorbereitung, Durchführung und/oder Auswertung einer solchen Messung. Durch (teil-)automatisierte Auswertung ist effizientes Feedback möglich, das Lernende zur besseren Selbsteinschätzung und Lehrende zur Aufdeckung von Defiziten nutzen können, jeweils mit Möglichkeit zur Nachbesserung.

Die Technologien können zur Unterstützung der Leistungserbringung eingesetzt werden und damit den klassischen Leistungsnachweisen ebenbürtig sein: dazu zählen z. B. Weblogs anstelle von Studientagebüchern der der Einsatz elektronischer Werkzeuge zur Simulation typischer Anwendungssituationen wie die Modellierung mathematischer Konstrukte mit MAPLE oder die Eclipse-Plattform für Programmieraufgaben. Eine Einordnung der Begriffe und Gegenüberstellung von elektronischen mit traditionellen Verfahren ist z. B. bei Rüdel in [1] und [2] zu finden (siehe dazu auch die Abb. auf der rechten Seite).

E-Assessments können die Hochschullehre in ganz unterschiedlichen Einsatzszenarien anreichern. Insofern sie didaktisch sinnvoll eingesetzt werden, siehe dazu u. a. [3], können sie zur Verbesserung der Qualität der Lehre beitragen - wobei die Qualität in diesem Fall z. B. in einer effizienten Auswertung, schnellem Feedback oder einer motivierenden Wirkung auf Studierende gemessen werden kann.

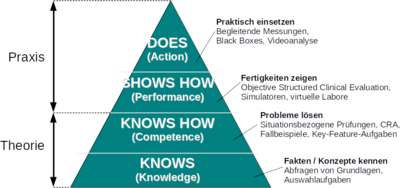

Elektronische Leistungsmessung nach Leistungsniveau

Miller[4] identifiziert vier Ebenen (proficiency levels), die Lernende beim Aufbau von Fertigkeiten durchlaufen. Diese Ebenen bauen jeweils aufeinander auf und repräsentieren den Grad der Professionalisierung eines Lernenden auf dem Weg vom Anfänger zum Experten. Während die unteren Ebenen Theorie und Erkenntnisgewinn (Cognition) beschreiben, repräsentieren die darüber liegenden Ebenen deren Umsetzung in die Praxis (Behaviour). Die elektronische Leistungsmessung richtet sich nach dem Grad der Professionalisierung und muss daher an die jeweilige Ebene angepasst sein.

- Knowledge (Wissen): Grundlage der Professionalisierung ist das Wissen um Fakten und Konzepte. Um deren Verständnis abzufragen, verwenden zugehörige Messungen z.B. Multiple-Choice-Aufgaben. Ein Beispiel ist das Konzept „Rechts vor Links“, dessen Grundlagen bei der Führerscheinprüfung behandelt werden.

- Competence (Problemlösung): Im darauf aufbauenden Schritt kann ein Lernender das vorhandene Faktenwissen zur Problemlösung einsetzen. In diesem Fall sind situationsbezogene Prüfungen oder Fallbeispiele sinnvoll, die eine angemessene Anwendung bereits gelernter Fakten überprüfen können. Beispiel aus der Führerscheinprüfung ist die Darstellung einer Verkehrssituation mit der Frage, was in diesem Fall zu tun ist.

- Performance (Fertigkeiten): Die folgende Ebene umfasst praktische Fertigkeiten eines Lernenden; sie verlässt den reinen Erkenntnisbereich und bezieht sich auf erlerntes Verhalten. Hier geht es darum, Handlungsweisen nicht nur zu beschreiben oder verstanden zu haben, sondern diese gezielt erbringen zu können. Möglichkeiten, um das elektronisch zu überprüfen, bieten z.B. virtuelle Labore oder Simulatoren. So könnte man bei der Führerscheinprüfung z.B. einen Fahrsimulator einsetzen, um die Fahrtüchtigkeit der Prüflinge zu erproben..

- Action (Können): Als Experte wendet der Lernende schließlich Wissen, Problemlösekompetenz und Fertigkeiten in der Praxis an. Durch Beobachtung und Aufzeichnung kann dieses Verhalten bestimmt und analysiert werden. Beispiele sind Fahrtenschreiber in Fahrzeugen, Black Boxes in Flugzeugen oder die Videoanalyse von Bewegungsabläufen bei Sportlern, um Optimierungspotential aufzudecken.

Reine Wissensprüfungen bergen die Gefahr, dass man Prüflingen aufgrund ihres Wissens (träges Wissen) fälschlicherweise Können zuschreibt bzw. umgekehrt vermutet, dass wenn bestimmtes Wissen (implizites Wissen) fehlt, auch zugehöriges Können nicht vorhanden ist. [5] Bei einer idealen Prüfung wählt der Prüfende daher einen Prüfungstyp, der dem jeweiligen Professionalisierungsgrad entspricht. Für Hochschulen bedeutet dies, dass die Möglichkeiten für den Einsatz elektronischer Prüfungen davon abhängen, wie praxisorientiert sie ausbildet.

Kritische Betrachtung

Vorteile und Mehrwerte

- Multimediale Elemente integrierbar (Audio, Video, Animation)

- Antworten sind besser lesbar (aber abhängig von der Tippgeschwindigkeit)

- Mischen von Fragen/Antworten nach Zufallsprinzip erschwert Täuschungen

- (Teil-)automatisierte Auswertung spart Korrekturzeit (setzt aber korrekte Antworten voraus)

- Mehr Auswertungsobjektivität, weniger subjektive Einflüsse

- Vergleich von Leistungen ist einfacher/übersichtlicher

- Qualität von Fragen leichter zu untersuchen (Item-Analyse)

- Übertragung von Ergebnissen (z.B. in Prüfungsverwaltungssysteme) weniger fehleranfällig

- Stufenförmige & adaptive Prüfungsverläufe sind modellier- und realisierbar

- Fragepools wiederverwendbar & austauschbar (z.B. Lehrverbund, Weiterentwicklung bzw. Ausbau denkbar)

- Antworten beliebig oft (spurlos) durch Prüflinge änderbar

- Prüfung mit Ergebnissen ist digital archivierbar

Nachteile und Herausforderungen

- Umfangreiche Vorarbeiten sind nötig (Fragepools erstellen, etc.)

- Hohe Kosten/Investitionen für den Aufbau von Testcentern, Prüfungsräumen, etc.

- Im Falle von Outsourcing: völlige Abhängigkeit von Full-Service-Anbietern

- Anfälligkeit für Pannen, keine 100%-ige Zuverlässigkeit (z.B. bei Stromausfall)

- Unterschiedliche Kenntnisstände (von Prüflingen und Prüfern) beim Umgang mit IKT, Schulungen und Probeklausuren notwendig

- Neue Manipulationsformen erfordern zusätzliche Sicherheitskonzepte (Chat, USB-, Netzzugriff, etc.)

- Unzureichende Flexibilität der Prüfungsordnungen

- Hoher Aufwand zur Herstellung von Rechtssicherheit

- Geforderte langjährige Archivierung fraglich (Träger?)

- Einziger Standard (IMS QTI) wird kaum unterstützt

- Automatische Auswertung nicht überall sinnvoll/geeignet

- System soll „Mitwachsen“ mit steigenden Anforderungen bzw. hochschul- und fachtypische Anforderungen erfüllen

Charakteristika elektronischer Assessments

Ein E-Assessment besteht aus unterschiedlichen Elementen und folgt verschiedenen Prinzipien. Lehrende können es - je nach Zielsetzung - so gestalten, dass es zu Veranstaltungstyp und Einsatzzweck passt. Die Abb. rechts zeigt Charakteristika, die ein E-Assessment ausmachen; ihre Beschreibung schließt sich an.

- Zweck: Zielsetzung und Zweck prägen das Wesen eines E-Assessments maßgeblich. Daher sind zunächst Leistungen und Qualifikationen zu identifizieren, die sie messen soll. Geht es z. B. um Sachkompetenz, kann es reichen, Ergebnisse der gestellten Aufgaben zu erfassen und auszuwerten. Bei Methodenkompetenz ist hingegen der Lösungsweg wichtig, mit dem Prüflinge die Aufgaben bearbeiten, während bei Sozialkompetenz eher ihr Verhalten untereinander im Vordergrund steht.

- Art: Abhängig von ihrem Bezug zum Lernprozess sind verschiedene E-Assessments durchführbar. Diagnostische Assessments identifizieren z. B. den Stand der Prüflinge vorab, um Lehre besser zu planen oder passende Kurse zuzuordnen. Formative Assessments helfen, den Lernprozess in eine erfolgreiche Richtung zu lenken, während summative Assessments den Lernerfolg im Anschluss feststellen. Statische Assessments geben eine Schablone vor, in die sich Prüflinge durch ihre Leistungen einordnen, so dass ein Prüfender sie vergleichend beurteilen kann. Adaptive Assessments hingegen passen Schwierigkeitsgrad und Themen dynamisch an, um Fähigkeiten oder Schwachstellen von Prüflingen individuell einzugrenzen.

- Form: Wie im vorab bereits beschrieben, richtet sich die Form eines E-Assessments nach dem Leistungsniveau der Prüflinge. Auf der Ebene der Fakten und Konzepte geht es darum, das Grundlagenwissen der Prüflinge zu bestimmen, z. B. mit Multiple-Choice-Aufgaben. Eine Gegenüberstellung, welche Aufgabentypen sich hier für welche Lernziele anbieten, findet sich z. B. bei Vogt & Schneider [6]. Um die Anwendung von Fakten und damit die Problemlösefähigkeiten der Prüflinge zu testen, bieten sich situationsbezogene Assessments oder Fallbeispiele an. Sollen Prüflinge hingegen erlernte Fertigkeiten zeigen, können sie dies z. B. in Simulatoren oder virtuellen Laboren. Schließlich helfen begleitende Messungen, z. B. Black Boxes, bei der Analyse alltäglicher Abläufe.

- Prüfender: Der Einsatz von IKT vereinfacht das Einbeziehen Dritter in die Bewertung von Leistungen. Bei klassischen E-Assessments geben Lehrende (Teacher Assessment) korrekte Antworten für eine automatisierte Auswertung vor. Sollen sich Prüflinge hingegen selbst einschätzen (Self Assessment), wie z. B. bei Lernfortschrittskontrollen in reinen E-Learning-Einheiten üblich, ist zusätzliches Feedback im Sinne von Lösungswegen oder weiterführenden Hinweise nötig. Die Auswertung von Eingaben durch andere Prüflinge oder Gruppen (Peer/Group Assessment) setzt hingegen Kriterienkataloge voraus, an denen sie diese zur Bewertung orientieren können. Laut Bogner[7] verschmelzen dadurch Lernende und Lernprozess stärker miteinander, was sich positiv auf den Lernerfolg auswirken kann.

- Ort: Assessments auf dem Campus, z. B. innerhalb einer Veranstaltung oder Übung, sind i. d. R. anders gestaltet als Assessments von zu Hause aus. Zudem ist von Bedeutung, ob eine Assessment beaufsichtigt sein muss, weil z. B. Täuschungen erschwert werden sollen, oder ob es lediglich der Wiederholung dient und an beliebigen Orten stattfinden kann. Vorgegebene Assessmentorte setzen vorinstallierte Arbeitsplätze voraus, z. B. ein Testcenter wie es die Uni Bremen einsetzt. Für mobile Assessments kann man z. B. einen Hörsaal mit Tablet-PCs oder Clickern ausstatten, auf dem Teilnehmer ihre Eingaben vornehmen - oder gleich deren Smartphones verwenden.

- Zeit: Diagnostische oder summative Assessments finden i. d. R. einmal pro Lernabschnitt statt, während formative Assessments den Lernprozess auch über mehrere Abschnitte hinweg kontinuierlich begleiten. Summative Assessments dauern häufig länger, da sie Stoff des gesamten Lernprozesses umfassen, während sich Assessments zur Wiederholung oft nur auf den letzten Lernabschnitt beziehen.

- Bewertung: Die Auswertung von Eingaben erfolgt, jeweils abhängig vom Aufgabentyp, entweder manuell, teilweise oder vollständig automatisiert. Eine Beurteilung der Ergebnisse liegt im didaktischen Ermessen des Lehrenden, insofern nicht in einer Ordnung oder Moduldeskriptor anders vorgeschrieben. Traditionell findet dazu die Abbildung erreichter Punkte auf eine vorgegebene Notenskala statt. Innovative Formen beziehen z. B. das Lernerkollektiv in die Bewertung von Einzelleistungen ein, um ihr Qualitätsbewusstsein zu schulen. Prüflinge können ihre Antworten aber auch selbst beurteilen, z.B. im Rahmen von Confidence-based Marking (siehe dazu u.a. Gardner-Medwin & Gahan[8]). Hierbei machen sie über ihre Antworten hinaus noch Angaben zum eigenen Zutrauen in diese Antworten.

- Feedback: Prüflinge können direkt im Anschluss an ein Assessment eine Rückmeldung erhalten oder erst verzögert, z. B. nach einer Qualitätskontrolle durch die Lehrenden (die dabei vielleicht den Notenspiegel aufgrund der per Itemanalyse ermittelten Aufgabenschwierigkeit anpassen). Das Feedback kann schriftlich erfolgen - als automatische Antwort eines Prüfungssystems - oder mündlich durch den Bewertenden, der dabei individuelle Probleme anspricht. Die Reichweite des Feedbacks reicht von einem "hat bestanden" bis zur detaillierten Analyse von Schwachstellen mit einer individuellen Beratung. Durch die Antworten und statistischen Auswertungen erhalten Lehrende ebenfalls Feedback. Dadurch erfahren sie, welche Aufgaben besonders schwierig waren, was besonders gut verstanden wurde und welche Inhalte noch einmal aufgegriffen oder wiederholt werden sollten.

Abhängig von der Ausgestaltung dieser dargestellten Charakteristika sind unterschiedliche Einsatzszenarien von E-Assessments vorstellbar.

Literatur

Siehe den Bereich Literatur für eine Gesamtübersicht zum Thema.

- Daniel Biella, Dieter Huth, Michael Striewe et al.: Organisation und Implementierung PC-gestützter Prüfungen an der Universität Duisburg-Essen, e-teaching.org, 2010, Download als PDF

- Johannes Hartig, Eckhard Klieme (Hrsg.): Möglichkeiten und Voraussetzungen technologiebasierter Kompetenzdiagnostik, Bildungsforschung Band 20, Bonn/Berlin, 2007, Download als PDF

- Lutz P. Michel: Digitales Prüfen und Bewerten im Hochschulbereich, Studie im Auftrag der Themengruppe "Innovationen in Lern‐ und Prüfungsszenarien", Hochschulforum Digitalisierung, Berlin, März 2015, Download als PDF

- Jona Florian Stieler: Validität summativer Prüfungen - Überlegungen zur Gestaltung von Klausuren, ISBN: 3-938076-36-4, Janus Presse, Bielefeld, 2011, Download als PDF

- Michael Vogt, Stefan Schneider: E-Klausuren an Hochschulen: Didaktik – Technik – Systeme – Recht – Praxis, Koordinationsstelle Multimedia, JLU Gießen, 2009, Download als PDF

- Klaus Wannemacher: Computergestützte Prüfungsverfahren, in Michael H. Breitner, Beate Bruns und Franz Lehner (Hrsg.): Neue Trends im E-Learning – Aspekte der Betriebswirtschaftslehre und Informatik, ISBN: 978-3-7908-1917-5, Physica Verlag, Heidelberg, 2007, S. 427-440

- Carsten Wolf (Hrsg.): E-Assessment, Zeitschrift für E-Learning, Lernkultur und Bildungstechnologie, Nr. 1/2010, ISSN: 1992-9579, Studienverlag, Innsbruck, 2010, Abstract

- Zentrales eLearning-Büro der Universität Hamburg (Hrsg.): eAssessment, ePrüfungen, ePortfolios, Hamburger eLMAGAZIN, Ausgabe #02, August 2009, Download als PDF

- Zentrales eLearning-Büro der Universität Hamburg (Hrsg.): eAssessment auf dem Prüfstand, Hamburger eLMAGAZIN, Ausgabe #07, Dezember 2011, Download als PDF

Weiterführende Informationen

- Denkbare Einsatzszenarien

- Checkliste zur Durchführung von E-Assessments

- Funktionsumfang ausgewählter E-Prüfungssysteme

- Verschiedene Aufgabentypen

- Einführung und Ausbau von E-Assessments

- Qualität von E-Assessments

- Literaturübersicht zum Thema

- Linksammlung zu E-Assessments

Literaturnachweise

- ↑ 1,0 1,1 Cornelia Rüdel: Was ist eAssessment?, In: eAssessment, ePrüfungen, ePortfolios, Hamburger eLMAGAZIN, Ausgabe #02, S. 22-24, Zentrales eLearning-Büro der Universität Hamburg, Hamburg, 2009, Download als PDF

- ↑ Cornelia Rüdel: Was ist E-Assessment?, In Cornelia Rüdel, Schewa Mandel (Hrsg.): 'E-Assessment: E-Assessment: Einsatzszenarien und Erfahrungen an Hochschulen, GMW Band 56, S. 11-22, Waxmann, Münster, 2010

- ↑ Gabi Reinmann: Bologna in Zeiten des Web 2.0 - Assessment als Gestaltungsfaktor, Arbeitsbericht Nr. 16, Universität Augsburg, 2007, Download als PDF

- ↑ 4,0 4,1 George E. Miller: The Assessment of Clinical Skills/Competence/Performance, in Academic Medicine, Ausgabe 65 (9), S. 63-67, 1990, Download als PDF (Abgerufen am 14.06.2010)

- ↑ Georg Hans Neuweg: Das Können prüfen - Plädoyer für eine andere Prüfungsdidaktik, in: GdWZ - Grundlagen der Weiterbildung, Ausgabe 12 (2001) 5, S. 202-205, Download als PDF (Abgerufen am 27.05.2010)

- ↑ Michael Vogt, Stefan Schneider: E-Klausuren an Hochschulen: Didaktik – Technik – Systeme – Recht – Praxis, Koordinationsstelle Multimedia, JLU Gießen, 2009, Download als PDF

- ↑ Christian Bogner: Studentisches Feedback im Bachelor - Eine empirische Untersuchung zur Effektivität und Qualität eines angepassten Peer-Assessment-Verfahrens, in A. Back, P. Baumgartner, G. Reinmann et al. (Hrsg): zeitschrift für e-learning - lernkultur und bildungstechnologie, ISSN: 1992-9579, Themenheft E-Assessment, S. 36-49, Studienverlag, Innsbruck, 2010

- ↑ A.R. Gardner-Medwin, M. Gahan: Formative and Summative Confidence-Based Assessment, in: Proceedings of the 7th CAA Conference, S. 147-155, Loughborough University, Loughborough, 2003, Download als PDF (Abgerufen am 15.07.2010)