Didaktik: Unterschied zwischen den Versionen

(→Assessmenttyp festlegen) |

|||

| Zeile 103: | Zeile 103: | ||

* Videoanalyse (z.B. an Sporthochschulen) | * Videoanalyse (z.B. an Sporthochschulen) | ||

* Portfolio (als Kombination verschiedener Möglichkeiten) | * Portfolio (als Kombination verschiedener Möglichkeiten) | ||

| + | |||

| + | Die Uni Bern stellt unter "Toolbox-Assessment" eine Online-Entscheidunghilfe für Lehrende zur Verfügung. Diese hilft bei der Auswahl eines passenden Assessmenttyps, indem sie Anforderungen der Lehrenden abfragt und mit einer Vielzahl möglicher Assessments abgleicht. Im Ergebnis wird ein Ranking der passendsten Assessments (mit zugehöriger Erklärung) dargestellt. Siehe dazu auch <ref>T. Tribelhorn: ''"Toolbox Assessment" - ein hochschuldidaktischer Service im virtuellen Raum (Praxis- und Werkstattbericht)'', in: K. Rummler (Hrsg.): ''Lernräume gestalten - Bildungskontexte vielfältig denken'', Reihe Medien in der Wissenschaft, Band 67, S. 207 - 212, Waxmann Verlag, Münster, 2014, [http://www.waxmann.com/fileadmin/media/zusatztexte/3142Volltext.pdf Download als PDF]</ref>. | ||

=== Aufgabentypen auswählen === | === Aufgabentypen auswählen === | ||

Version vom 10. September 2014, 06:35 Uhr

Inhaltsverzeichnis

Didaktische Entscheidungen

Wer den Einsatz von E-Prüfungen plant, muss eine Reihe von didaktischen Entscheidungen treffen, die hier im Einzelnen besprochen werden sollen. Rechtliche, organisatorische und technische Fragen, die sich im Zusammenhang mit dem Einsatz von E-Prüfungen stellen, werden dort thematisiert.

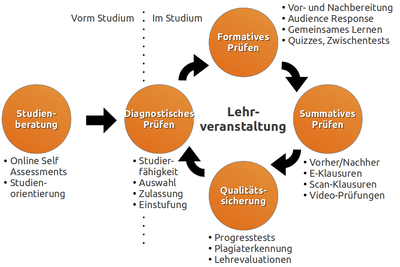

Zweck identifizieren

An Hochschulen gibt es verschiedene Bereiche, in denen sich E-Prüfungen einsetzen lassen. Diese sind im Abschnitt Einsatzszenarien ausführlich beschrieben. Mithilfe von E-Prüfungen nimmt man Bewertung über eine Person vor, die nicht für sich stehen, sondern einem bestimmten Zweck dienen:

Diagnostisches Assessment

Als Eingangstest soll eine solche Prüfung die Vorkenntnisse von Prüflingen identifizieren, als prognostische Prüfung den zu erwartenden Lernerfolg vorhersagen. Das Ergebnis dieser Prüfung hilft dabei, die Lehre besser zu planen oder geeignete Veranstaltungstypen bzw. Lehrmethoden auszusuchen. Bsp.: Zulassungs- und Einstufungstests

Formatives Assessment

Um einen möglichst großen Lernerfolg zu produzieren, ist der Lernprozess kontinuierlich an Erfordernisse der Lernenden anzupassen. Eine formative Prüfung begleitet das Lernen dazu als Zwischenmessung und versucht, das bereits erzielte Lernergebnis festzustellen. Bsp.: Vor- und Nachbereitung von Lehrveranstaltungen, Clicker & Audience Response Systems

Summatives Assessment

Eine summative Prüfung misst Leistungen oder Fertigkeiten im Anschluss an das Lernen und damit den abschließenden Lernerfolg. Dieser gibt den Grad der Übereinstimmung von Lernzielen mit dem erreichten Lernergebnis an. Bsp.: Elektronische Klausuren

Qualitätssicherung

Durch Sicherstellen notwendigen Grundwissens, Identifizieren geeigneter Kurse, Anpassung der Lehre an individuelle Erfordernisse der Studierenden sowie Ermitteln des Lernerfolges tragen E-Prüfungen generell zur Anreicherung der Hochschullehre bei. Bsp.: Progresstests aber auch Lehrevaluationen

Lernziele bestimmen

Ob oder wie stark ein Lernziel (bisher) erreicht wurde, lässt sich nur prüfen, wenn solche Lernziele vorab klar spezifiziert wurden.

Ein Lernziel ist die Erwartung an ein bestimmtes Lernergebnis, das Lernende bezogen auf eine bestimmte Lerneinheit oder einen Lernabschnitt erreichen sollen. Bloom[2] unterschied zu dem Zweck unterschiedliche Klassen von Lernzielen:

- Kognitive Ziele: Wissen, Verstehen, Anwenden, Analyse, Synthese, Evaluation

- Affektive Ziele: Aufmerksamwerden, Beachten, Reagieren, Werten, Strukturierter Aufbau eines Wertesystems, Erfüllt sein durch einen Wert oder eine Wertstruktur

- Psychomotorische Ziele: Imitation, Manipulation, Präzision, Handlungsgliederung, Naturalisierung

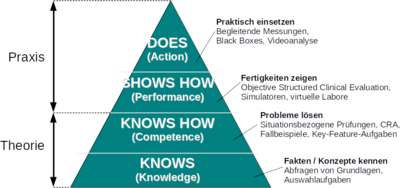

Diese Klassen beschreiben einfache theoretische bis hin zu komplexen praktischen Fertigkeiten. Abhängig davon, wie theorie- oder praxisnah die zu überprüfenden Fertigkeiten sind, ist ein jeweils unterschiedlicher Einsatz elektronischer Leistungsmessung denkbar. Miller[1] hat zu dem Zweck verschiedene Ebenen der Professionalisierung identifiziert (siehe Abb. rechts) und diesen - je nach Praxisnähe - jeweils unterschiedliche Verfahren zur Leistungsmessung zugeordnet.

Damit sie Lernziele besser einordnen können, haben Anderson & Krathwool[3] das Grundmodell von Bloom erweitert und eine eigene Taxonomie beschrieben. Diese bezieht neben den verschiedenen Wissensdimensionen auch Schritte des kognitiven Prozesses ein.

Die Abbildung auf der rechten Seite zeigt eine beispielhafte Ausprägung dieses Modells nach Rex Heer[4], weitere Informationen dazu finden sich im Handout der ISU. Die darin angegebenen Lernziele bestehen beispielhaft jeweils aus Verb und Objekt, wobei das Verb den kognitiven Prozess und das Objekt das Wissen beschreibt, das konstruiert bzw. erlernt werden soll. Eine ausführliche Beschreibung verschiedener Taxonomien mit Beispielen und Einsatzideen für den Unterricht findet sich auch bei Peter Baumgartner[5].

Sind Lernziele bereits im Voraus spezifiziert, können Lehrende auf ihrer Grundlage leichter passende Aufgaben erstellen, die das Erreichen dieser Ziele im Nachhinein überprüfen sollen. Die nachfolgende Tabelle listet noch einmal die Dimensionen nach Anderson & Krathwool auf und beinhaltet Beispiele für mögliche Prüfungsfragen (bzw. Links dorthin).

| Dimension des Wissens | Dimension des kognitiven Prozesses | |||||

1. Erinnern

|

2. Verstehen

|

3. Anwenden

|

4. Analysieren

|

5. Bewerten (Evaluieren)

|

6. Erzeugen

| |

A. Faktenwissen

|

A.1 | A.2 | A.3 | A.4 | A.5 | A.6 |

B. Konzeptionelles Wissen

|

B.1 | B.2 | B.3 | B.4 | B.5 | B.6 |

C. Prozedurales Wissen

|

C.1 | C.2 | C.3 | C.4 | C.5 | C.6 |

D. Meta-kognitives Wissen

|

D.1 | D.2 | D.3 | D.4 | D.5 | D.6 |

Assessmenttyp festlegen

Auf Basis ihrer Anforderungen können sich Lehrende dann überlegen, wie ihre E-Assessments gestaltet sein sollten. Als Grundgerüst für diese Überlegungen können die bereits beschriebenen Charakteristika elektronischer Prüfungen dienen. Beispiele dafür sind:

- Fragebögen (z.B. mit einer Reihe von MC-Fragen)

- Fallbeispiele (z.B. praxisnahes Abarbeiten eines typischen Falls)

- Simulationen (z.B. Arbeiten in virtuellen Laboren)

- Audience Response Systeme (z.B. um direktes und schnelles Feedback zu erhalten)

- Werkzeugeinsatz (z.B. Nutzung typischer elektronischer Arbeitswerkzeuge zur Aufgabenerfüllung)

- Black Box Messungen (im Sinne eines kontinuierlichen "Fahrtenschreibers" zur Leistungsmessung)

- Videoanalyse (z.B. an Sporthochschulen)

- Portfolio (als Kombination verschiedener Möglichkeiten)

Die Uni Bern stellt unter "Toolbox-Assessment" eine Online-Entscheidunghilfe für Lehrende zur Verfügung. Diese hilft bei der Auswahl eines passenden Assessmenttyps, indem sie Anforderungen der Lehrenden abfragt und mit einer Vielzahl möglicher Assessments abgleicht. Im Ergebnis wird ein Ranking der passendsten Assessments (mit zugehöriger Erklärung) dargestellt. Siehe dazu auch [6].

Aufgabentypen auswählen

Sind die Lernziele festgelegt, sind im nächsten Schritt passende Typen für zugehörige Aufgaben auszuwählen. Mayer, Hertnagel & Weber[7] haben deshalb ein Modell zur computergestützten Lernzielüberprüfung entworfen, das sehr stark an die Taxonomie von Anderson & Krathwool[3] angelehnt ist. Dieses Computer Supported Evaluation of Learning Goals (CELG) Modell ist in der nachfolgenden Tabelle dargestellt und ordnet den jeweiligen Kategorien passende Aufgabentypen zu.

| Dimension des Wissens | Dimension des kognitiven Prozesses | |||

| Reproduzieren | Verstehen/Anwenden | Reflektieren/Evaluieren | Erschaffen | |

| Faktenwissen |

1) Ja/Nein |

3 -- 8 |

3 -- 6 |

9 -- 11 |

| Konzeptwissen | 1 -- 8 | 3 -- 11 |

3 -- 6 |

9 -- 11 |

| Prozedurales Wissen | 3 -- 8 | 3 -- 11 |

3 -- 6 |

9 -- 11 |

Siehe zur Zuordnung von Lernzielen zu Aufgabentypen auch die Auswahl des Aufgabentyps im Rahmen der verschiedener Aufgabentypen. Weitere Informationen zur Auswahl und Gestaltung passender Aufgaben finden sich u.a. im Vortrag von Volkhard Fischer (Folien als PDF) zur Verbesserung von Prüfungen mit elektronischen Eingabegeräten von der N2E2-Fachtagung E-Prüfungen. Dort finden sich auch Aufzeichnungen der Vorträge.

Einsatzszenario auswählen

Vor dem Hintergrund zu welchem Zweck, welche Lernziele mit welchen Aufgaben erfasst werden sollen, lässt sich ein geeignetes Einsatzszenario auswählen.

Eine Beschreibung der verschiedenen Möglichkeiten sowie Praxisbeispiele finden sich bei den Einsatzszenarien. Zugehörige Experten sowie von diesen in bestimmten Szenarien eingesetzte Technologien sind in der Kompetenzmatrix aufgeführt.

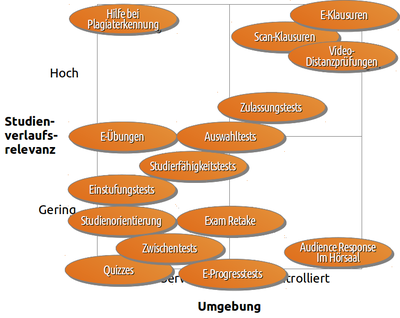

In der Abbildung (rechts) sind diese verschiedene Einsatzszenarien eingeordnet in eine Matrix nach Relevanz für den Studienverlauf und der Notwendigkeit nach Überwachung. So ist eine benotete E-Klausur (oben rechts) z.B. sehr relevant für den weiteren Studienverlauf, da ein Scheitern daran ein Studium im schlimmsten Fall beenden kann. Aus diesem Grund finden E-Klausuren i.d.R. in überwachter Umgebung statt. Quizzes oder Zwischentests (unten links) hingegen sind kaum relevant für den Studienverlauf. Studierende können sie beliebig oft durchführen, z.B. bis sie das Thema verstanden haben. Eine Aufsicht ist dazu nicht nötig. Es scheint eine gute Idee zu sein, für den Einstieg in E-Prüfungen nicht direkt mit "gefährlichen" Einsatzszenarien zu beginnen, sondern ungefährlichere auszuwählen. Lehrende können auf diese Weise leicht den Umgang mit den neu eingesetzten Technologien lernen und deren Zuverlässigkeit erproben.

Ist die Entscheidung für ein bestimmtes Einsatzszenario gefallen, ist im nächsten Schritt eine geeignete Metapher zu bestimmen, welche die Verwendung elektronischer Verfahren erleichtert. Soll z.B. eine bereits schriftlich vorliegende Version lediglich "elektronisiert" werden, damit diese die Lernenden auch auf anderen Kanälen als bisher erreichen kann? Oder sollen ganz neue Wege gegangen werden, die z.B. multimediale Elemente einbeziehen, die in der traditionellen schriftlichen Form nicht einbezogen werden konnten?

Aufgaben erstellen

siehe z.B.

Weiterführende Informationen

- Verschiedene Aufgabentypen

- Erstellen von Multiple-Choice-Aufgaben

- Organisation und Durchführung elektronischer Prüfungen

- Ansprechpartner und Experten

- Technik und Systeme

- Vergleich verschiedener E-Prüfungssysteme

- Qualität von E-Prüfungen

- An Hochschulen eingesetzte E-Prüfungssysteme (ZKI-Umfrage)

Literaturnachweise

- ↑ 1,0 1,1 George E. Miller: The Assessment of Clinical Skills/Competence/Performance, in Academic Medicine, Ausgabe 65 (9), S. 63-67, 1990, Download als PDF (Abgerufen am 14.06.2010)

- ↑ Benjamin S. Bloom: Taxonomie von Lernzielen im kognitiven Bereich, 5. Auflage, Beltz Verlag, Weinheim, 1976

- ↑ 3,0 3,1 L.W. Anderson, D.R. Krathwohl, P.W. Airasian, K.A. Cruikshank, R.E. Mayer, P.R. Pintrich, J. Raths, M.C. Wittrock: A taxonomy for learning, teaching, and assessing: A revision of Bloom's Taxonomy of Educational Objectives, New York, Longman, 2001

- ↑ Model created by: Rex Heer Iowa State University, Center for Excellence in Learning and Teaching, Updated January, 2012, Licensed under a Creative Commons Attribution- NonCommercial-ShareAlike 3.0 Unported License. For additional resources, see: www.celt.iastate.edu/teaching/RevisedBlooms1.html

- ↑ Peter Baumgartner: Taxonomie von Unterrichtsmethoden - Ein Plädoyer für didaktische Vielfalt, ISBN: 978-3-8309-2546-0Waxmann Verlag, Münster, 2011

- ↑ T. Tribelhorn: "Toolbox Assessment" - ein hochschuldidaktischer Service im virtuellen Raum (Praxis- und Werkstattbericht), in: K. Rummler (Hrsg.): Lernräume gestalten - Bildungskontexte vielfältig denken, Reihe Medien in der Wissenschaft, Band 67, S. 207 - 212, Waxmann Verlag, Münster, 2014, Download als PDF

- ↑ Horst O. Mayer, Johannes Hertnagel, Heidi Weber: Lernzielüberprüfung im eLearning, ISBN: 3-486-58844-3, Oldenbourg Verlag, München/Wien, 2009

Literatur

- Manfred Amelang, Lothar Schmidt-Atzert: Psychologische Diagnostik und Intervention, 4. Auflage, ISBN-13: 978-3540284628, Springer, Berlin, 2006, bei Google Books

- L.W. Anderson, D.R. Krathwohl, P.W. Airasian, K.A. Cruikshank, R.E. Mayer, P.R. Pintrich, J. Raths, M.C. Wittrock: A taxonomy for learning, teaching, and assessing: A revision of Bloom's Taxonomy of Educational Objectives, New York, Longman, 2001

- Hermann Astleitner: Die lernrelevante Ordnung von Aufgaben nach der Aufgabenschwierigkeit, in: Josef Thonhauser (Hrsg.): Aufgaben als Katalysatoren von Lernprozessen. Eine zentrale Komponente organisierten Lehrens und Lernens aus der Sicht von Lernforschung, Allgemeiner Didaktik und Fachdidaktik, Münster, S. 65-80, 2008

- Peter Baumgartner: Taxonomie von Unterrichtsmethoden - Ein Plädoyer für didaktische Vielfalt, ISBN: 978-3-8309-2546-0Waxmann Verlag, Münster, 2011

- Benjamin S. Bloom: Taxonomie von Lernzielen im kognitiven Bereich, 5. Auflage, Beltz Verlag, Weinheim, 1976

- Christian Bogner: Studentisches Feedback im Bachelor - Eine empirische Untersuchung zur Effektivität und Qualität eines angepassten Peer-Assessment-Verfahrens, in A. Back, P. Baumgartner, G. Reinmann et al. (Hrsg): zeitschrift für e-learning - lernkultur und bildungstechnologie, ISSN: 1992-9579, Themenheft E-Assessment, S. 36-49, Studienverlag, Innsbruck, 2010

- Louis Deslauriers, Ellen Schelew, Carl Wieman: Improved Learning in a Large-Enrollment Physics Class, Science, Vol. 332, Nr. 6031, S. 862-864, 13. Mai 2011, Artikel im Volltext

- Steven M. Downing: Assessment of knowledge with written test forms, in: G. R. Norman, C. P. M. van der Vleuten, D. I. Newble (Hrsg.): International handbook for research in medical education, Dordrecht, NL, S. 647-672, 2002

- Stephen W. Draper: Catalytic assessment: understanding how MCQs and EVS can foster deep learning, in: British Journal of Educational Technology, Vol. 40, No. 2, S. 285-293, 2009

- John Erpenbeck, Lutz von Rosenstiel: Handbuch Kompetenzmessung, 2. Aufl. Stuttgart, 2007

- Johannes Hartig, Eckhard Klieme (Hrsg.): Möglichkeiten und Voraussetzungen technologiebasierter Kompetenzdiagnostik, Bildungsforschung Band 20, Bonn/Berlin, 2007, Download als PDF

- James C. Impera, David Foster: Item and Test Development Strategies to Minimize Test Fraud, in: Steven M. Downing, Thomas M. Haladyna: Handbook of Test Development, Mahwah, N.J., S. 91-114, 2006

- Institut für Aus-, Weiter- und Fortbildung Medizinische Fakultät Universität Bern: Kompetent prüfen. Handbuch zur Planung, Durchführung und Auswertung von Facharztprüfungen, 1999, Download als PDF

- Veronika Kopp, Andreas Möltner, Martin R. Fischer: Key-Feature-Probleme zum Prüfen von prozeduralem Wissen: Ein Praxisleitfaden, in: GMS Zeitschrift für Medizinische Ausbildung, ISSN 1860-3572, 23(3), 2006, Artikel als PDF

- Sue M. Legg: Handbook on Testing and Grading, Gainsville, Florida, 1991, Download als PDF

- Gustav A. Lienert, Ulrich Raatz: Testaufbau und Testanalyse, 6. Auflage, ISBN-13: 978-3621274241, BeltzPVU, 1998, bei Google Books

- Horst O. Mayer, Johannes Hertnagel, Heidi Weber: Lernzielüberprüfung im eLearning, ISBN: 3-486-58844-3, Oldenbourg Verlag, München/Wien, 2009

- George E. Miller: The Assessment of Clinical Skills/Competence/Performance, in Academic Medicine, Ausgabe 65 (9), S. 63-67, 1990, Download als PDF

- Georg Hans Neuweg: Das Können prüfen - Plädoyer für eine andere Prüfungsdidaktik, in: GdWZ - Grundlagen der Weiterbildung, Ausgabe 12 (2001) 5, S. 202-205, Download als PDF

- A. H. Perlini, D. L. Lind, D. L., B. D. Zumbo: Context effects on examinations: The effect of time, item order and item difficulty, in: Canadian Psychology, Vol. 39, S. 299-307, 1998

- Gabi Reinmann: Bologna in Zeiten des Web 2.0 - Assessment als Gestaltungsfaktor, Arbeitsbericht Nr. 16, Universität Augsburg, 2007, Download als PDF

- Gabi Reinmann: Kompetenz - Qualität - Assessment: Hintergrundfolie für das technologiebasierte Lernen, Preprint, wird erscheinen in: M. Mühlhäuser, W. Sesink, A. Kaminski, (Hrsg.): Interdisziplinäre Zugänge zu technologiegestütztem Lernen, (Arbeitstitel), Münster, 2009, Download als PDF

- Hans-Gerd Ridder, Hans-Jürgen Bruns, Stefan Brünn: Online- und Multimediainstrumente zur Kompetenzerfassung, QUEM-report, Schriften zur beruflichen Weiterbildung, Heft 86, ISSN: 0944-4092, Berlin, 2004, Download als PDF

- Michael C. Rodriguez: Choosing an item format, in G. Tindal, Thomas M. Haladyna (Hrsg.): Large-scale assessment programs for all students: Validity, Technical Adequacy, and Implementation, Mahwah, NJ. S. 213-231, 2002

- E. Schaper, A. Tipold, J. P. Ehlers: Einsatz von Key Feature Questions (KFQ) in der Tiermedizin, in: Jahrestagung der Gesellschaft für Medizinische Ausbildung (GMA), München, 2011, Abstract

- Stephen G. Sireci, April L. Zenisky: Innovative Item Formats in Computer-Based Training: In Pursuit of Improved Construct Representation, in: Steven M. Downing, Thomas M. Haladyna (Hrsg.): Handbook of Test Development, Mahwah, N.J., S. 329-348, 2006

- Wissenschaftsrat: Empfehlungen zur Qualitätsverbesserung von Lehre und Studium, Berlin, 2008, Download als PDF