Didaktik: Unterschied zwischen den Versionen

(→Praxisgrad festlegen) |

K (→Lernzieltyp identifizieren) |

||

| Zeile 30: | Zeile 30: | ||

Eine Beschreibung der verschiedenen Möglichkeiten sowie Praxisbeispiele finden sich bei den [[Einsatzszenarien]]. Zugehörige Experten sowie von diesen in bestimmten Szenarien eingesetzte Technologien sind in der [[Kompetenzmatrix]] aufgeführt. | Eine Beschreibung der verschiedenen Möglichkeiten sowie Praxisbeispiele finden sich bei den [[Einsatzszenarien]]. Zugehörige Experten sowie von diesen in bestimmten Szenarien eingesetzte Technologien sind in der [[Kompetenzmatrix]] aufgeführt. | ||

| − | === | + | === Lernzielklasse identifizieren === |

[[Bild:Professionalisierungsgrad.png|thumb|400px|Professionalisierungebenen in Anlehnung an Miller<ref name="miller" />]] | [[Bild:Professionalisierungsgrad.png|thumb|400px|Professionalisierungebenen in Anlehnung an Miller<ref name="miller" />]] | ||

Ein Lernziel ist die Erwartung an ein bestimmtes Lernergebnis, das Lernende bezogen auf eine bestimmte Lerneinheit oder einen Lernabschnitt erreichen sollen. Bloom<ref>Benjamin S. Bloom: ''Taxonomie von Lernzielen im kognitiven Bereich'', 5. Auflage, Beltz Verlag, Weinheim, 1976</ref> unterschied zu dem Zweck unterschiedliche Klassen von Lernzielen: | Ein Lernziel ist die Erwartung an ein bestimmtes Lernergebnis, das Lernende bezogen auf eine bestimmte Lerneinheit oder einen Lernabschnitt erreichen sollen. Bloom<ref>Benjamin S. Bloom: ''Taxonomie von Lernzielen im kognitiven Bereich'', 5. Auflage, Beltz Verlag, Weinheim, 1976</ref> unterschied zu dem Zweck unterschiedliche Klassen von Lernzielen: | ||

Version vom 29. Februar 2012, 08:44 Uhr

Inhaltsverzeichnis

Einsatzentscheidungen

Einsatzbereich identifizieren

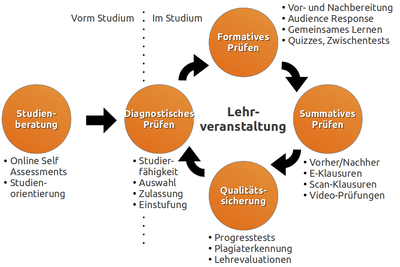

An Hochschulen gibt es verschiedene Bereiche, in denen sich E-Prüfungen einsetzen lassen. Diese sind im Abschnitt Einsatzszenarien ausführlich beschrieben. Wer ihren Einsatz plant, muss zunächst Zweck und Ziele dieser elektronischen Prüfung bestimmen. Verschiedene Gebiete, in denen bereits elektronisch geprüft wird, sind z.B.:

Diagnostisches Assessment

- Studienorientierung und Studienberatung: Orientierung geben, typische Fragen und Probleme des gewünschten Fachgebiets präsentieren und erproben, Stärken und Schwächen von Kandidaten ermitteln, Empfehlungen für Studiengänge erteilen

- Zulassungs- und Einstufungstests: Geeignete Kandidaten auswählen, Vorhandensein notwendigen Vorwissens oder von Vorleistungen sicherstellen, passende Kurse bestimmen, um Studierende nicht zu über- oder unterfordern

Formatives Assessment

- Vor- und Nachbereitung von Lehrveranstaltungen: Lehrveranstaltungen an Vorwissen anpassen, Zeitmanagement optimieren, Feedback zum Verständnis der Inhalte im Anschluss einholen

- Clicker & Audience Response Systems: Wissen, Stimmungen und Meinungen bereits innerhalb einer Lehrveranstaltung abfragen, direkte Reaktionsmöglichkeit, Anregen von Diskussionen zum jeweils aktuellen Thema

- Gemeinsames Lernen: Unterstützen gemeinsamen Lernens, Zuteilung individueller Aufgaben, Förderung der Diskussion zum Lösungsweg, individuelle Anwendung auf eigene Aufgaben

- Quizzes & Zwischentests: Wiederholung von Inhalten, weiteren Aufnahmekanal zur Verfügung stellen, Feedback zum Verständnis geben

Summatives Assessment

- Vorher/Nachher-Prüfungen: Kenntnisse bzw. Leistungen vor und nach dem Lernprozess vergleichen, um neben dem Stand des Prüflings auch den konkreten Lernerfolg des Lernprozesses zu bestimmen

- Elektronische Klausuren: Bewertung des Lernerfolgs im Anschluss an einen Lernprozess, Benotung von Leistungen

Qualitätssicherung

- Lehrevaluationen: Ermitteln der Zufriedenheit mit Lehrveranstaltungen, Erheben von Verbesserungsvorschlägen, Qualitätssicherung

- Progresstests: Ermitteln des Lernfortschritts im Rahmen einer kompletten Ausbildung durch regelmäßige Erhebungen

Einsatzszenario auswählen

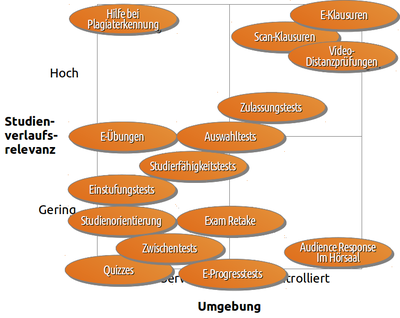

In der Abbildung (rechts) sind diese verschiedene Szenarien eingeordnet in eine Matrix nach Relevanz für den Studienverlauf und der Notwendigkeit nach Überwachung. So ist eine benotete E-Klausur (oben rechts) z.B. sehr relevant für den weiteren Studienverlauf, da ein Scheitern daran ein Studium im schlimmsten Fall beenden kann. Aus diesem Grund finden E-Klausuren i.d.R. in überwachter Umgebung statt. Quizzes oder Zwischentests (unten links) hingegen sind kaum relevant für den Studienverlauf. Studierende können sie beliebig oft durchführen, z.B. bis sie das Thema verstanden haben. Eine Aufsicht ist dazu nicht nötig. Es scheint eine gute Idee zu sein, für den Einstieg in E-Prüfungen nicht direkt mit "gefährlichen" Szenarien zu beginnen, sondern ungefährlichere auszuwählen. Lehrende können auf diese Weise leicht den Umgang mit den neu eingesetzten Technologien lernen und deren Zuverlässigkeit erproben.

Ist die Entscheidung für ein bestimmtes Szenario gefallen, ist im nächsten Schritt eine geeignete Metapher zu bestimmen, welche die Verwendung elektronischer Verfahren erleichtert. Soll z.B. eine bereits schriftlich vorliegende Version lediglich "elektronisiert" werden, damit diese die Lernenden auch auf anderen Kanälen als bisher erreichen kann? Oder sollen ganz neue Wege gegangen werden, die z.B. multimediale Elemente einbeziehen, die in der traditionellen schriftlichen Form nicht einbezogen werden konnten?

Eine Beschreibung der verschiedenen Möglichkeiten sowie Praxisbeispiele finden sich bei den Einsatzszenarien. Zugehörige Experten sowie von diesen in bestimmten Szenarien eingesetzte Technologien sind in der Kompetenzmatrix aufgeführt.

Lernzielklasse identifizieren

Ein Lernziel ist die Erwartung an ein bestimmtes Lernergebnis, das Lernende bezogen auf eine bestimmte Lerneinheit oder einen Lernabschnitt erreichen sollen. Bloom[2] unterschied zu dem Zweck unterschiedliche Klassen von Lernzielen:

- Kognitive Ziele: Wissen, Verstehen, Anwenden, Analyse, Synthese, Evaluation

- Affektive Ziele: Aufmerksamwerden, Beachten, Reagieren, Werten, Strukturierter Aufbau eines Wertesystems, Erfüllt sein durch einen Wert oder eine Wertstruktur

- Psychomotorische Ziele: Imitation, Manipulation, Präzision, Handlungsgliederung, Naturalisierung

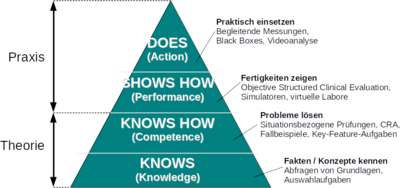

Diese Klassen beschreiben einfache theoretische bis hin zu komplexen praktischen Fertigkeiten. Abhängig davon, wie theorie- oder praxisnah die zu überprüfenden Fertigkeiten sind, ist ein jeweils unterschiedlicher Einsatz elektronischer Leistungsmessung denkbar. Miller[1] hat zu dem Zweck verschiedene Ebenen der Professionalisierung identifiziert (siehe Abb. rechts) und diesen - je nach Praxisnähe - jeweils unterschiedliche Verfahren zur Leistungsmessung zugeordnet.

Prüfungstyp festlegen

Auf Basis ihrer Anforderungen können sich Lehrende dann überlegen, wie ihre E-Prüfung gestaltet sein sollte. Als Grundgerüst für diese Überlegungen können die bereits beschriebenen Charakteristika elektronischer Prüfungen dienen. Beispiele dafür sind:

- Fragebögen (z.B. mit einer Reihe von MC-Fragen)

- Fallbeispiele (z.B. praxisnahes Abarbeiten eines typischen Falls)

- Simulationen (z.B. Arbeiten in virtuellen Laboren)

- Audience Response Systeme (z.B. um direktes und schnelles Feedback zu erhalten)

- Werkzeugeinsatz (z.B. Nutzung typischer elektronischer Arbeitswerkzeuge zur Aufgabenerfüllung)

- Black Box Messungen (im Sinne eines kontinuierlichen "Fahrtenschreibers" zur Leistungsmessung)

- Videoanalyse (z.B. an Sporthochschulen)

- Portfolio (als Kombination verschiedener Möglichkeiten)

Lernziele bestimmen

Anderson & Krathwool[3] haben Blooms Grundmodell erweitert und eine eigene Taxonomie für Lernziele beschrieben, die neben den verschiedenen Wissensdimensionen auch Schritte des kognitiven Prozesses einbezieht. Die Abbildung auf der rechten Seite zeigt eine beispielhafte Ausprägung dieses Modells nach Rex Heer[4], weitere Informationen dazu finden sich im Handout der ISU. Die dort jeweils beispielhaft angegebenen Lernziele bestehen jeweils aus Verb und Objekt, wobei das Verb den kognitiven Prozess und das Objekt das Wissen beschreibt, das konstruiert bzw. erlernt werden soll. Eine ausführliche Beschreibung verschiedener Taxonomien mit Beispielen und Einsatzideen für den Unterricht findet sich auch bei Peter Baumgartner[5].

Spezifizieren Lehrende ihre Ziele im Voraus, können sie darauf aufbauend leichter Aufgaben erstellen, um das Erreichen dieser Lernziele im Nachhinein zu überprüfen. Zudem helfen Taxonomien dabei, bestehdene Prüfungsfragen besser kategorisieren und damit beurteilen zu können. Die nachfolgende Tabelle listet noch einmal die Dimensionen nach Anderson & Krathwool auf und beinhaltet Beispiele für mögliche Prüfungsfragen (bzw. Links dorthin).

| Dimension des Wissens | Dimension des kognitiven Prozesses | |||||

1. Erinnern

|

2. Verstehen

|

3. Anwenden

|

4. Analysieren

|

5. Bewerten (Evaluieren)

|

6. Erzeugen

| |

A. Faktenwissen

|

A.1 | A.2 | A.3 | A.4 | A.5 | A.6 |

B. Konzeptionelles Wissen

|

B.1 | B.2 | B.3 | B.4 | B.5 | B.6 |

C. Prozedurales Wissen

|

C.1 | C.2 | C.3 | C.4 | C.5 | C.6 |

D. Meta-kognitives Wissen

|

D.1 | D.2 | D.3 | D.4 | D.5 | D.6 |

Aufgabentyp auswählen

Sind die Lernziele festgelegt, sind im nächsten Schritt passende Typen für zugehörige Aufgaben auszuwählen. Mayer, Hertnagel & Weber[6] haben deshalb ein Modell zur computergestützten Lernzielüberprüfung entworfen, das sehr stark an die Taxonomie von Anderson & Krathwool[3] angelehnt ist. Dieses Computer Supported Evaluation of Learning Goals (CELG) Modell ist in der nachfolgenden Tabelle dargestellt und ordnet den jeweiligen Kategorien passende Aufgabentypen zu.

| Dimension des Wissens | Dimension des kognitiven Prozesses | |||

| Reproduzieren | Verstehen/Anwenden | Reflektieren/Evaluieren | Erschaffen | |

| Faktenwissen |

1) Ja/Nein |

3 -- 8 |

3 -- 6 |

9 -- 11 |

| Konzeptwissen | 1 -- 8 | 3 -- 11 |

3 -- 6 |

9 -- 11 |

| Prozedurales Wissen | 3 -- 8 | 3 -- 11 |

3 -- 6 |

9 -- 11 |

Weitere Informationen zur Auswahl und Gestaltung passender Aufgaben finden sich u.a. im Vortrag von Volkhard Fischer (Folien als PDF) zur Verbesserung von Prüfungen mit elektronischen Eingabegeräten von der N2E2-Fachtagung E-Prüfungen. Dort finden sich auch Aufzeichnungen der Vorträge.

Aufgaben erstellen

siehe z.B.

Technologien aussuchen & einsetzen

- siehe z.B. im Bereich Technik

Abläufe organisieren

- siehe z.B. den Bereich Organisation

Qualitätssicherung

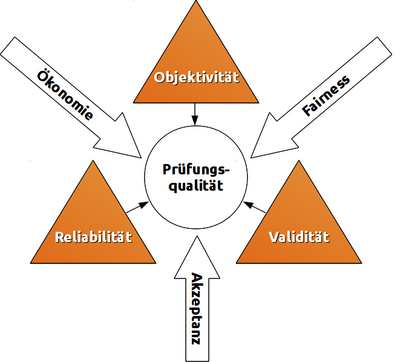

Lienert & Raatz[7] sowie Amelang & Schmidt-Atzert[8] identifizieren verschiedene Gütekriterien eines Tests. Stieler[9] untersucht diese Kriterien für den pädagogischen Bereich, insbesondere zur Gestaltung von Klausuren.

Hauptgütekriterien

Bauen aufeinander auf, wobei jede Stufe ist nur nach Erfüllung der vorhergehenden zu erreichen ist.

- Objektivität: Unabhängigkeit vom Untersucher; verschiedene Prüfer kommen bei gleichen Prüflingen zum gleichen Ergebnis.

- bei Durchführung der Prüfung (Durchführungsobjektivität)

- bei Auswertung der Antworten (Auswertungsobjektivität)

- bei Interpretation der Ergebnisse (Interpretationsobjektivität)

- Reliabilität: Grad der Messgenauigkeit; Wiederholungen erbringen bei gleichen Beteiligten gleiche Ergebnisse.

- durch Paralleltests: streng vergleichbare Tests wiederholen

- durch Retests: gleichen Test wiederholen

- innere Konsistenz: messbar z.B. als Cronbachs Alpha

- durch Testhalbierung: Test in gleichwertige Hälften teilen und als 2 eigene Tests auswerten (siehe Paralleltest)

- durch Konsistenzanalyse: Ermittlung der Reliabilität auf indirektem Weg über Aufgabenschwierigkeit und Trennschärfe

- Validität: Ergebnisse des Tests korrelieren mit den zu prüfenden Kompetenzen.

- Inhaltsvalidität: Test prüft Wissen/Kompetenzen/Leistung, die mit Lehrzielen übereinstimmen.

- Konstruktvalidität Test ist geeignet, inhaltliche Kompetenzen zu erfassen (und nicht z.B. die Fähigkeit des Prüflings, Gedanken in kurzer Zeit aufzuschreiben/einzugeben).

- Kriteriumsvalidität: Testergebnisse stimmen mit empirischem Kriterium überein, das bereits vorliegt (konkurrente Validität, z.B. Schulnoten) oder erst später erkennbar wird (prognostische Validität, z.B. Studienerfolg).

Nebengütekriterien

- Akzeptanz: Test ist für Prüflinge transparent; keine Normen werden verletzt.

- Ökonomie: Nutzen übersteigt Kosten.

- Chancengerechtigkeit/Fairness: Gleiche Voraussetzungen für alle.

Spannungsfeld

Die genannten Kriterien können sich gegenseitig beeinflussen. Ein Beispiel: setzt man genügend Mittel und Zeit ein (Ökonomie), ist es möglich, eine Prüfung sehr objektiv, reliabel und valide zu gestalten. Das erhöht ebenso die Akzeptanz unter den Prüflingen. Sind hingegen hohe Reliabilität und Akzeptanz nicht wichtig, ist eine auch mit geringerem Mitteleinsatz möglich. Diese Faktoren sind jeweils im Einzelfall abzuwägen.

Itemanalyse

Itemanalyse bezeichnet die Verwendung statistischer Verfahren, um die Brauchbarkeit von Aufgaben (den sog. Items) zu beurteilen. Sie versucht deren Reliabilität zu erfassen und ist damit Voraussetzung, diese ggf. zu verbessern. Dies geschieht i.d.R. durch Analyse der Rohwertverteilung, Berechnung statistischer Kennwerte wie Itemschwierigkeit, Trennschärfe und Homogenität sowie durch Dimensionalitätsprüfung. Häufig wird die Itemanalyse mit Antworten einer Referenzgruppe durchgeführt, die der Zielgruppe (als Stichprobe) ähnlich ist.

- Rohwertverteilung: Durch grafische Darstellung der Ergebnisse besteht die Möglichkeit, die Verteilung mit der (gewünschten oder erwarteten) Normalverteilung zu vergleichen

- Itemschwierigkeit: Gibt das Verhältnis der Personen, die dieses Item richtig gelöst haben, zu sämtlichen Testteilnehmern an.

- Trennschärfe: Macht Aussagen über die Vorhersagbarkeit des Gesamtergebnisses aufgrund der Beantwortung des vorliegenden Items.

- Homogenität: Gibt an, wie sehr die unterschiedlichen Items eines Tests miteinander korrelieren, sowohl vom Inhalt als auch von ihrer Schwierigkeit.

- Dimensionalität: Beschreibt, ob ein Test nur ein Merkmal (eindimensionaler Test) oder mehrere Konstrukte bzw. Teil-Konstrukte erfasst (mehrdimensionaler Test).

Weiterführende Informationen

- Verschiedene Aufgabentypen

- Erstellen von Multiple-Choice-Aufgaben

- Organisation und Durchführung elektronischer Prüfungen

- Ansprechpartner und Experten

- Technik und Systeme

- Vergleich verschiedener E-Prüfungssysteme

- An Hochschulen eingesetzte E-Prüfungssysteme (ZKI-Umfrage)

Literaturnachweise

- ↑ 1,0 1,1 George E. Miller: The Assessment of Clinical Skills/Competence/Performance, in Academic Medicine, Ausgabe 65 (9), S. 63-67, 1990, Download als PDF (Abgerufen am 14.06.2010)

- ↑ Benjamin S. Bloom: Taxonomie von Lernzielen im kognitiven Bereich, 5. Auflage, Beltz Verlag, Weinheim, 1976

- ↑ 3,0 3,1 L.W. Anderson, D.R. Krathwohl, P.W. Airasian, K.A. Cruikshank, R.E. Mayer, P.R. Pintrich, J. Raths, M.C. Wittrock: A taxonomy for learning, teaching, and assessing: A revision of Bloom's Taxonomy of Educational Objectives, New York, Longman, 2001

- ↑ Model created by: Rex Heer Iowa State University, Center for Excellence in Learning and Teaching, Updated January, 2012, Licensed under a Creative Commons Attribution- NonCommercial-ShareAlike 3.0 Unported License. For additional resources, see: www.celt.iastate.edu/teaching/RevisedBlooms1.html

- ↑ Peter Baumgartner: Taxonomie von Unterrichtsmethoden - Ein Plädoyer für didaktische Vielfalt, ISBN: 978-3-8309-2546-0Waxmann Verlag, Münster, 2011

- ↑ Horst O. Mayer, Johannes Hertnagel, Heidi Weber: Lernzielüberprüfung im eLearning, ISBN: 3-486-58844-3, Oldenbourg Verlag, München/Wien, 2009

- ↑ Gustav A. Lienert, Ulrich Raatz: Testaufbau und Testanalyse, 6. Auflage, ISBN-13: 978-3621274241, BeltzPVU, 1998, bei Google Books

- ↑ Manfred Amelang, Lothar Schmidt-Atzert: Psychologische Diagnostik und Intervention, 4. Auflage, ISBN-13: 978-3540284628, Springer, Berlin, 2006, bei Google Books

- ↑ Jona Florian Stieler: Validität summativer Prüfungen - Überlegungen zur Gestaltung von Klausuren, ISBN: 3-938076-36-4, Janus Presse, Bielefeld, 2011, Download als PDF